参考书籍:冯乐乐 - 《Unity Shader入门精要》

1 - 渲染流水线

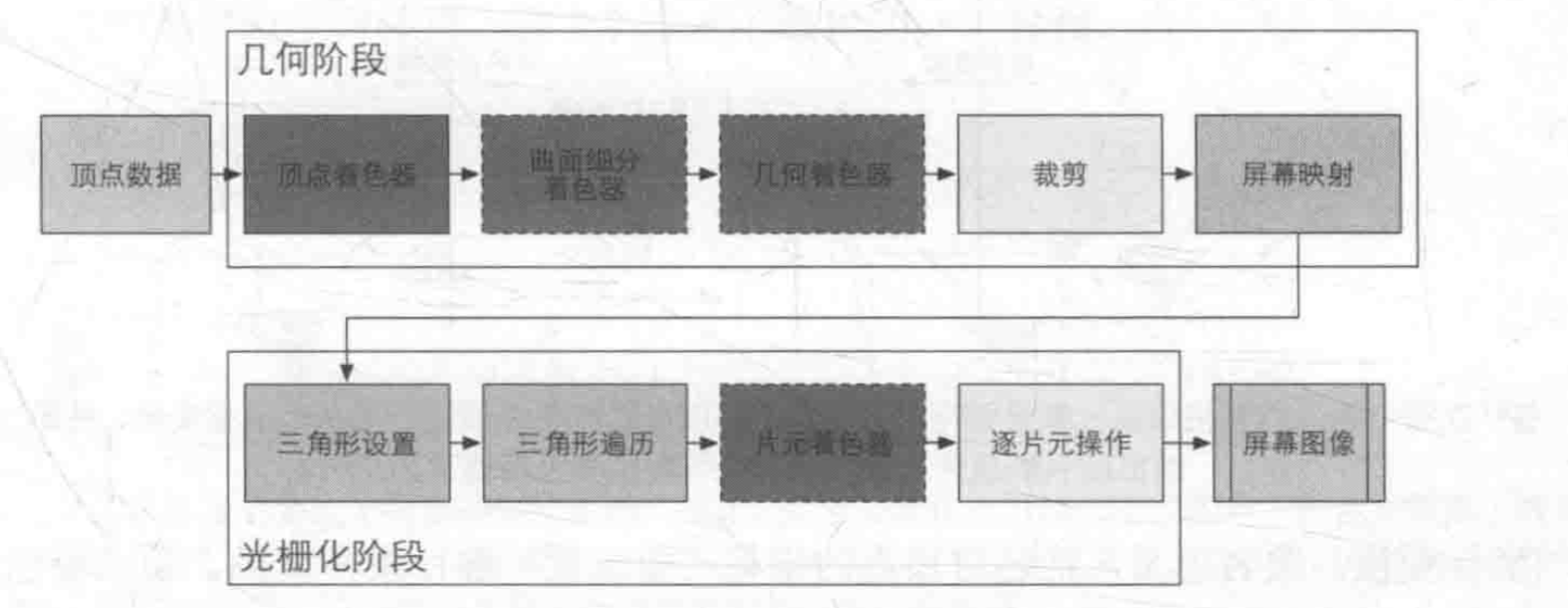

在《Render-Time Rendering,Third Edition》一书中,提出将一个渲染流程分为3各阶段:应用阶段(Application Stage)、几何阶段(Geometry Stage)、光栅化阶段(Rasterizer Stage)。

1.1 - 应用阶段

应用阶段(在CPU上):

将数据加载到显存

设置渲染状态

渲染状态:定义了场景中的网格是怎么被渲染的,使用了什么顶点、片元着色器,光源属性和材质等。

Draw Call

Draw Call:CPU告诉GPU如何去进行渲染的指令,即根据渲染状态和所有输入的顶点数据。

1.2 - 几何阶段

几何阶段:顶点数据通过顶点着色器等一系列着色器进行空间变换、顶点着色,最终经过裁剪映射到屏幕空间。

顶点着色器:最主要的工作是坐标变换、逐顶点光照。常用于实现顶点动画。一个最基本的顶点着色器需要完成工作是将顶点坐标转换到齐次剪裁空间中。

剪裁:剔除不在视野范围的物体数据。

屏幕映射:将每个图元的x和y坐标转换到屏幕坐标系下。

屏幕坐标系在OpenGL和DirectX中存在差异,OpenGL中是数学中常用的由左向右,由下向上的坐标系,DirectX则是由左往右,由上往下,符合人类的阅读顺序的坐标系。

如果发现得到的图像是反的,那么有可能是这个原因造成的。

1.3 - 光栅化阶段

光栅化阶段:计算每个图元覆盖了哪些像素,为这些像素计算它们的颜色。

三角形设置:计算光栅化一个三角网格所需的信息。

三角形遍历:检查每一个像素是否被一个三角网格覆盖,如果是就会生成一个片元。

片元不是真正意义上的像素,而是包含了很多状态的集合,这些状态用于计算每个像素的最终颜色。包括屏幕坐标,深度信息,以及其他从几何阶段输出的顶点信息例如:法线、纹理坐标等。

片元着色器:这个阶段可以完成许多渲染技术,其中最重要的就是纹理采样。

逐片元操作:决定每个片元的可见性,涉及很多测试工作:例如深度测试、模板测试。如果一个片元通过了所有的测试,那么就将这个片元的颜色值和已经存储在颜色缓冲区中的颜色进行混合。

理解模板测试和深度就能够理解之后章节提到的渲染队列,尤其是处理透明效果时出现的问题。如果一个片元通过了模板测试,那么他会进行下一个深度测试。

- 模板测试:通常用于限制渲染的范围。

- 深度测试:显示出离摄像机最近的物体,剔除其他被遮挡的部分。

- 合并:如果一个片元通过了模板测试和深度测试,那么就可以进行合并。对于半透明的物体,需要混合操作让这个物体看起来是透明的。混合类似于Photoshop中的图层混合模式,会根据透明通道的值进行相加、相减、相乘等。

- 此外,在Unity的渲染流水线中,深度测试是在片元着色器之前的,这种技术也称为Early-Z技术,通过尽可能地早知道哪些片元是会被舍弃的,提高了GPU的性能。

当图元经过了光栅化阶段的计算和测试后,就会显示到我们的屏幕上。我们的屏幕上显示的就是颜色缓冲区中的颜色值,为了避免我们看到那些正在光栅化的图元,GPU会使用双重缓冲(Double Buffering)策略。即对于场景的渲染是在幕后的后置缓冲(Back Buffer)中进行的,当场景被渲染到后置缓冲中,GPU就会交换后置缓冲和前置缓冲(Front Buffer)中的内容,由此来保证我们看到的图像总是连续的。

1.4 - Draw Call

Draw Call:Draw Call是CPU调用图像接口命令,如OpenGL或者DirectX中的相关命令,以指示GPU进行渲染的操作。

CPU和GPU之间如何实现并行工作?

使用命令缓冲区,其中包含的命令有很多,除了Draw Call以外还有改变渲染状态等。

为什么Draw Call多了会影响帧率?

分配内存、创建元数据这些操作多了会造成很多额外的性能开销,如果复制了很多小文件,那么这种性能开销会很大。

如何减少Draw Call?

减少Draw Call的方法有很多,比如:批处理

批处理是将很多的Draw Call合并成一个大的Draw Call,通过合并网格,适用于静态的物体,如将不会移动的地面合并。当然也可以对动态物体进行批处理,但是这些物体是不断移动的,因此每一帧都需要进行合并,这也会造成一定的性能开销。

为了减少Draw Call,需要注意:

- 尽量避免使用大量很小的网格,如果不可避免,那么可以考虑合并他们

- 尽量避免使用过多的材质,在不同的网格之间使用相同的材质。

1.5 - Shader在渲染流水线中扮演的角色

- Shader是GPU流水线上的一些可高度编程的阶段,由Shader编译出来的代码最终会运行在GPU上。

- 有一些特定的着色器:顶点着色器、片元着色器

- 依靠Shader我们可以控制渲染流水线上的细节,如使用顶点着色器来进行顶点变换或者传递数据,使用片元着色器来进行逐像素的渲染。

2 - Unity Shader基础

2.1 - Unity Shader 概述

参考资料

Writing Your First Shader In Unity - Rendering In Unity:https://www.youtube.com/watch?v=ZNvEM76Zi-c&list=PLX2vGYjWbI0RS_lkb68ApE2YPcZMC4Ohz&index=2

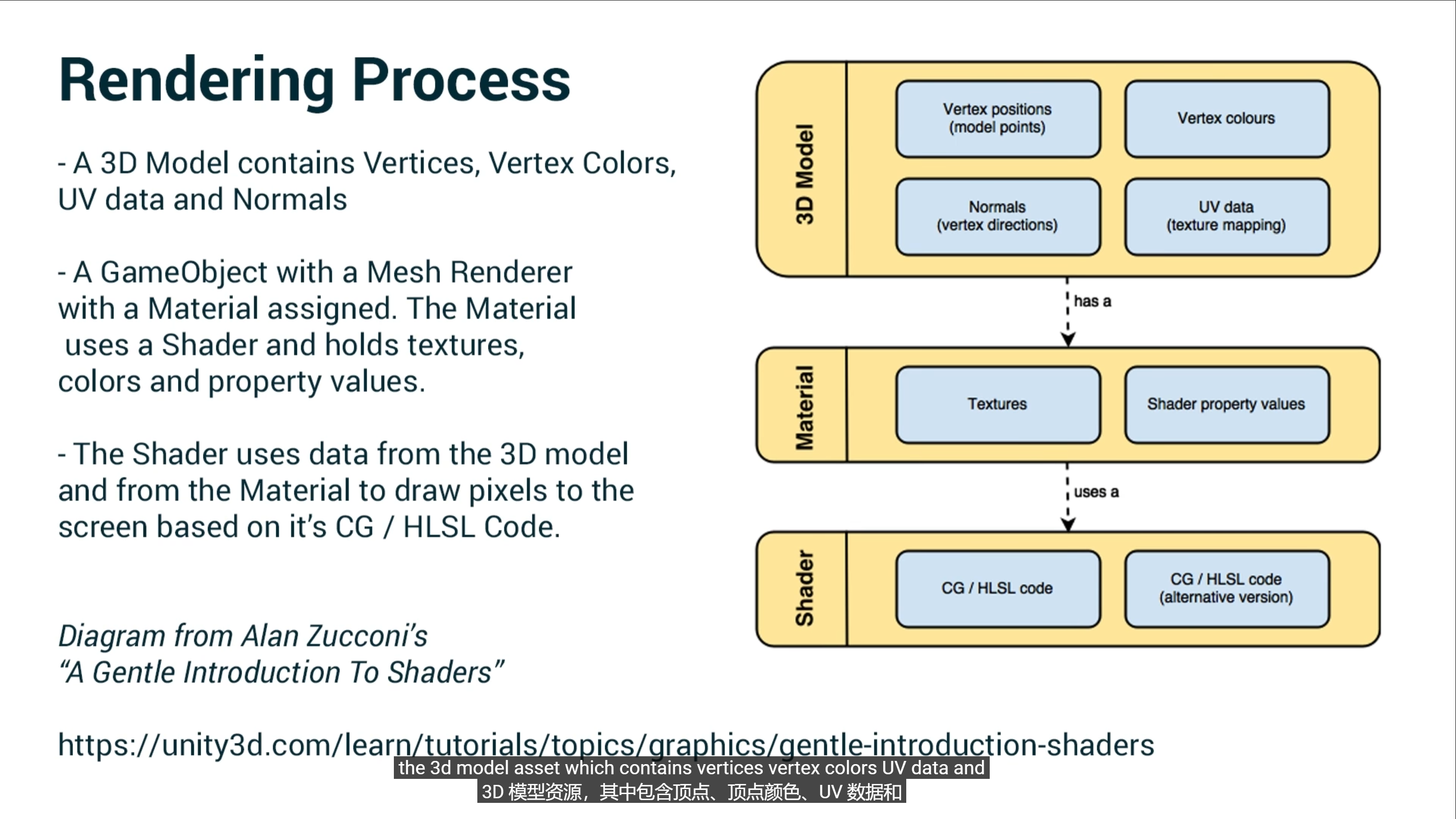

一个完整的渲染过程需要包括以下资产:3D模型、材质以及Shader

- 其中,3D模型包含顶点、顶点颜色、UV数据以及法线。

- 在Unity中,要渲染的游戏对象带有添加了材质的Mesh Render渲染器,材质声明了使用的Shader、纹理贴图、颜色以及属性信息。

- Shader使用来自3D模型和材质中的信息,使用CG/HLSL代码在屏幕上绘制像素。

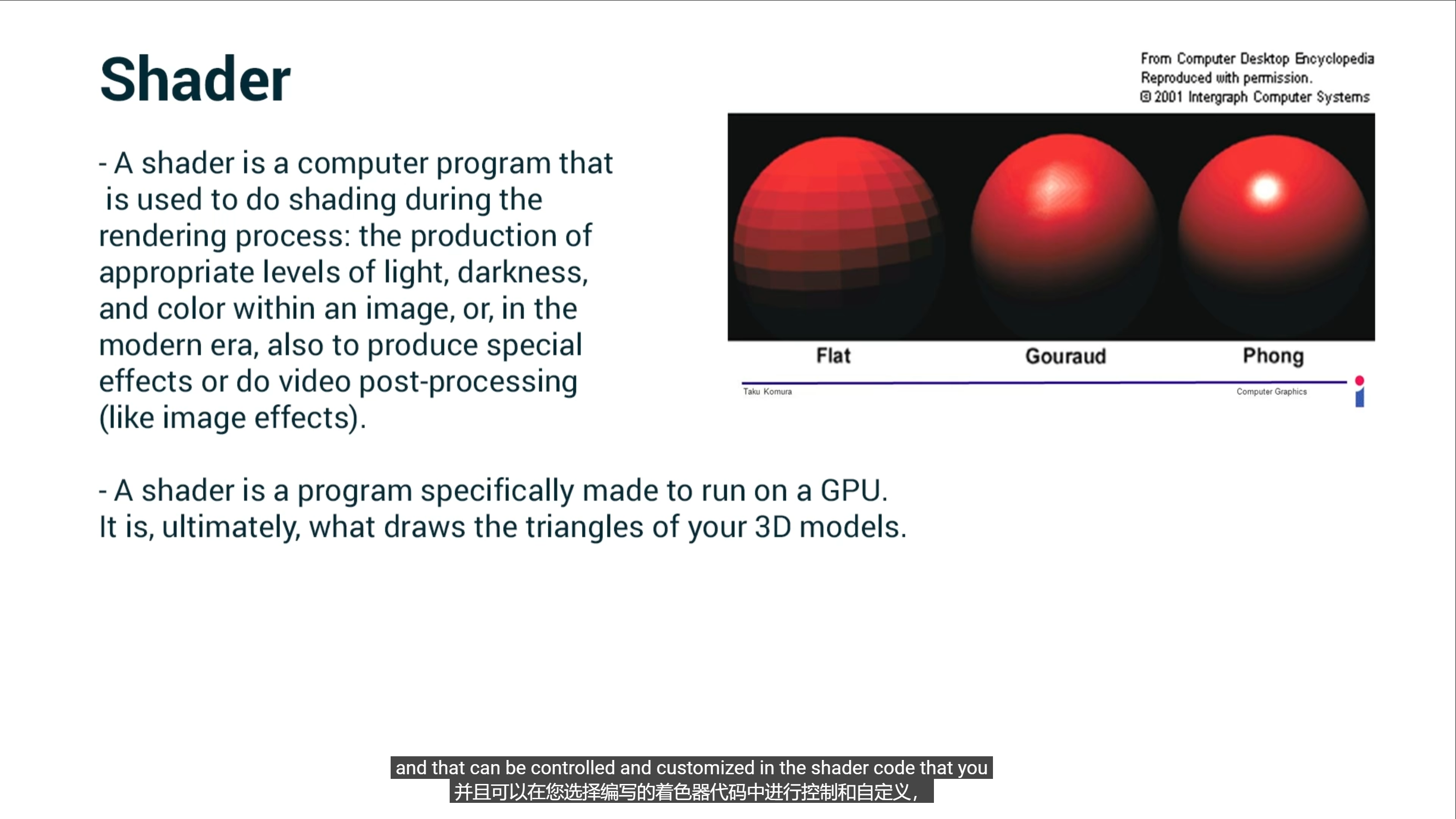

- Shader是一种计算机程序,在渲染过程中用于进行着色:在图像中产生适当的光亮、暗淡和颜色,或者在现代也用于产生特殊的平面效果或进行视频后期处理(如图像效果)。

- Shader是一个专门在GPU上运行的程序。它最终用于绘制你的3D模型的三角面。

一个Unity Shader的基本结构如下:

2

3

4

5

6

7

8

9

10

11

12

{

Properties

{

//属性

}

SubShader

{

//显卡A使用的子着色器

}

}

2.2 - SubShader

Unity可以包含多个SubShader语义,但至少要有一个。SubShader定义了一些列的Pass以及状态(**[RenderSetup])、标签([Tag])的设置。如果Pass**的数目过多,会造成性能的下降。

Unity会选择第一个能够在目标平台上运行的SubShader,如果都不支持的话就会使用Fallback语义中指定的Unity Shader。这样做的好处是能够在新旧的显卡上面呈现不同计算复杂度的画面。

以下是SubShader语义块包含的内容:

2

3

4

5

6

7

[Tags] //可选

[RenderSetup] //可选

Pass{

}

//Other Pass

}

2.2.1 - 状态设置

- 状态设置:ShaderLab提供的一系列渲染状态的设置指令,例如是否开启混合/深度测试。

| 状态名称 | 设置指令 | 解释 |

|---|---|---|

| Cull | Cull Back| Front |Off | 设置剔除指令,剔除背面/正面/关闭剔除 |

| ZTest | ZTest Less Greater | LEqual | GEqual | NotEqual | Always | 设置深度测试时使用的函数 |

| ZWrite | ZWrite On | Off | 开启/关闭深度写入 |

| Blend | Blend SrcFactor DstFactor | 开启并设置混合模式 |

当在SubShader中设置了上面的渲染状态之后,会应用到所有的Pass中,如果不想这样,那么可以在Pass中单独设置。

ZWrite off:这是深度写入(Z写入)的设置。将其设置为off表示在渲染此Shader时不会写入深度缓冲区。这意味着该对象将不会对后续的渲染产生深度测试的影响,而是始终绘制在已经渲染的像素之上,不考虑深度。Blend SrcAlpha OneMinusSrcAlpha:这是混合(Blending)的设置。它指定了使用源颜色的alpha通道和目标颜色的反相alpha通道进行混合。具体来说,SrcAlpha表示使用源颜色的alpha通道作为混合因子,OneMinusSrcAlpha表示使用目标颜色的反相alpha通道作为混合因子。这种混合方式常用于实现半透明效果,源颜色会根据其alpha值与背景进行混合,产生透明效果。https://docs.unity3d.com/530/Documentation/Manual/SL-Blend.html

2.2.2 - 标签

- 标签:SubShader的标签(**[Tag])是一个键值对,它用来告诉Unity希望怎样以及何时**渲染这个对象。

| 标签类型 | 说明 | 例子 |

|---|---|---|

| Queue | 控制渲染顺序 | Tags { “Queue”=”Transparent” } |

| RenderType | 对着色器进行分类,例如用来区别透明和不透明着色器 | Tags { “RenderType”=”Opaque” } |

| DisableBatching | 一些SubShader在只要批处理会出现问题,例如使用了模型空间下的坐标进行顶点动画。这时可以通过此标签来取消该SubShader对于批处理的使用。 | Tags { “DisableBatching”=”True” } |

| ForceNoShadowCasting | 控制该物体是否会投射阴影 | Tags { “ForceNoShadowCasting”=”True” } |

| IgnoreProjector | 如果该标签为**”True”,那么该物体不会受Projector的影响,通常用于半透明物体**。 | Tags { “IgnoreProjector”=”True” } |

| CanUseSpriteAtlas | 当该对象是Sprite时,将该标签设置为**”False”** | Tags { “CanUseSpriteAtlas”=”False” } |

| PreviewType | 指明材质面板该如何预览该材质,例如”Plane“、”Skybox“ | Tags { “PreviewType”=”Plane” } |

2.2.3 - Pass

- Pass语义块

以下是Pass语义块包含的内容:

2

3

4

5

[Name]

[Tag]

[RenderSetup]

}

我们可以在Pass中定义该Pass的名称,例如:

在ShaderLab中,我们可以使用UsePass命令来直接使用其他Unity Shader中的Pass

例如:

需要注意的是,Unity内部会将所有的Pass的名称转换成大写字母的表示,因此,在使用UsePass命令的时候必须使用大写形式的名字。

SubShader中的状态设置同样使用与Pass,在Pass中我们还可以使用固定管线的着色器。

在Pass中同样可以设置标签,但是不同于SubShader中的标签。

| 标签类型 | 说明 | 例子 |

|---|---|---|

| LightMode | 定义该Pass在Unity渲染流水线中的角色 | Tags { “LightMode”=”ForwardBase” } |

| RequireOptions | 当满足某些特定条件时才渲染该Pass | Tags { “RequireOptions”=”SoftVegetation” } |

除了上面定义的Pass之外,Unity Shader还支持一些特殊的Pass:

- UsePass:可以使用指令来复用其他Shader中的Pass

- GrabPass:负责抓取屏幕并将结果存储在一张纹理中,一边用于后续的Pass处理。

2.2.4 - Fallback

在各个SubShader语义块之后的,可以是一个Fallback指令,它用于告诉Unity,如果上面的SubShader都无法在这张显卡上运行,那就是用这个最低级的Shader。

它的语句如下:

2

Fallback off

另外,在渲染阴影纹理时,Unity会在每个Unity Shader中寻找一个阴影投射的Pass,通常情况下,我们不需要专门实现一个Pass,因为Fallback使用的内置Shader会包含这样一个通用的Pass,因此,对每个Unity Shder正确设置一个Fallback是非常重要的。

2.2.5 - 其他语义

除了上面的语义之外,Unity还包含以下不常用的语义:

- CustomEditor:自定义材质面板的编辑画面,用来扩展编辑界面

- Category:对Unity Shader中的命令进行分组

2.3 - Unity中的几种着色器类型

以下是Unity中内置的几种着色器:

表面着色器(Surface Shaders)采用了代码生成的方法,相比使用低级顶点/像素着色器程序,更容易编写光照着色器。使用基于物理的渲染方法。

表面着色器是顶点/片元着色器的更高一层的抽象,Unity为我们处理了很多光照细节,我们不需要在计算这些。

以下是一个表面着色器的示例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38Shader "Custom/TestSurfaceShader"

{

Properties

{

}

SubShader

{

Tags { "RenderType"="Opaque" }

LOD 200

CGPROGRAM

#pragma surface surf Standard fullforwardshadows

#pragma target 3.0

struct Input

{

float2 uv_MainTex;

};

half _Glossiness;

half _Metallic;

fixed4 _Color;

UNITY_INSTANCING_BUFFER_START(Props)

UNITY_INSTANCING_BUFFER_END(Props)

void surf (Input IN, inout SurfaceOutputStandard o)

{

fixed4 c = tex2D (_MainTex, IN.uv_MainTex) * _Color;

o.Albedo = c.rgb;

o.Metallic = _Metallic;

o.Smoothness = _Glossiness;

o.Alpha = c.a;

}

ENDCG

}

FallBack "Diffuse"

}表面着色器不关心Pass,只要使用纹理去填充颜色、法线纹理去填充法线,使用Lambert光照模型,其他的都交给Unity,

Unity还是会把它转换成一个包含多个Pass的顶点/片元着色器。

无光照着色器(Unlit Shaders)不与Unity的光源进行交互,适用于特殊效果,灵活性较高。

图像效果着色器(Image Effect Shaders)通常是一种后期处理效果,它读取源图像,对其进行一些计算,并将结果渲染到提供的目标图像中(例如使用Graphics.Blit)。

计算着色器(Compute Shaders)是在显卡上运行的程序,独立于正常的渲染流程。它们可用于大规模并行的GPU算法,或者加速游戏渲染的某些部分。旨在利用GPU的并行性来进行一些与常规渲染流水线无关的计算。

3 - Shader 相关数学基础

3.1 - 笛卡尔坐标系

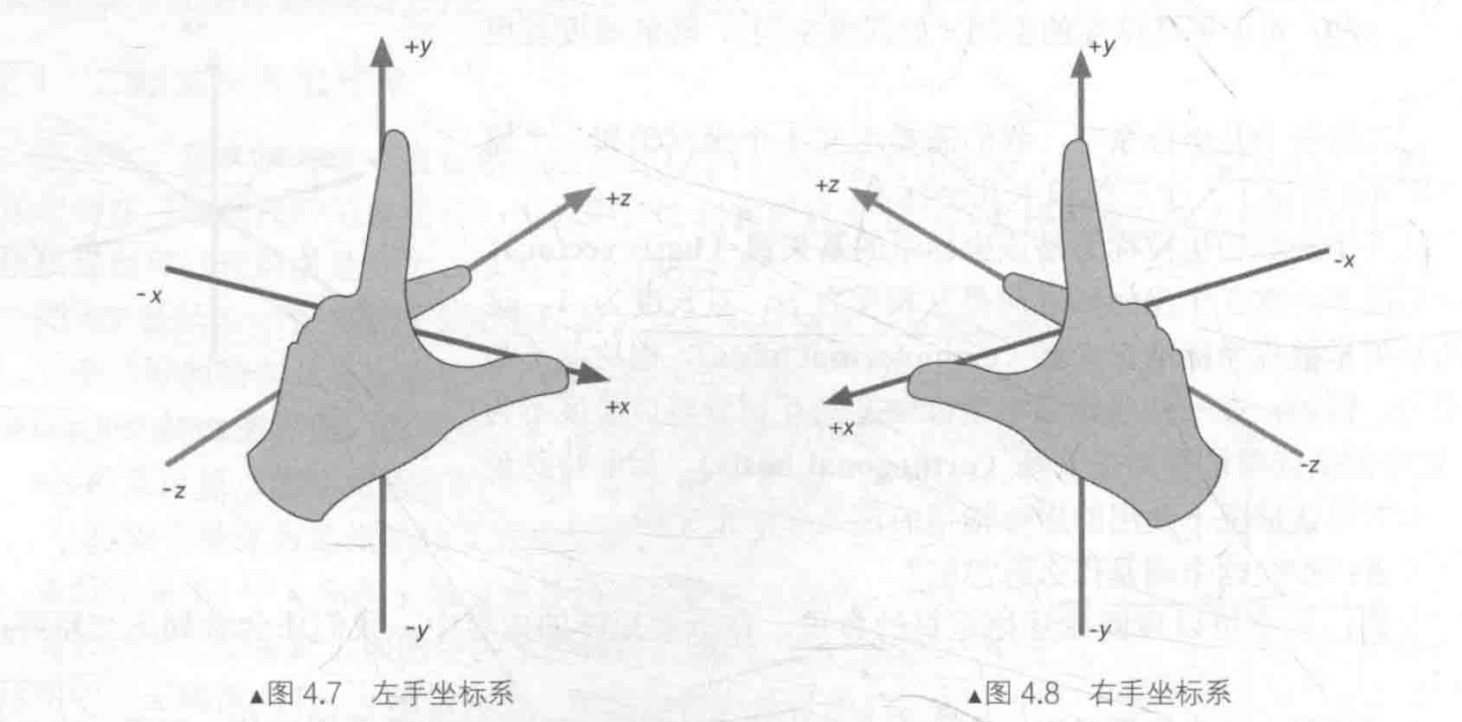

三维中的笛卡尔坐标系并不都是等价的,如果他们具有相同的旋向性,那么我们可以通过旋转的方式让他们的坐标轴重合。如果他们具有不同的旋向性,例如下图的左手坐标系和右手坐标系,那么就无法通过旋转的方式让他们的坐标系重合。

食指朝上,向上的方向就是y轴的正方向,中指朝前,向前的方向就是z轴的正方向,剩下的拇指的方向就是x轴的正方向。

在模型空间和世界空间中,Unity使用的是左手坐标系。蓝色代表z轴,绿色代表y轴,红色代表x轴。

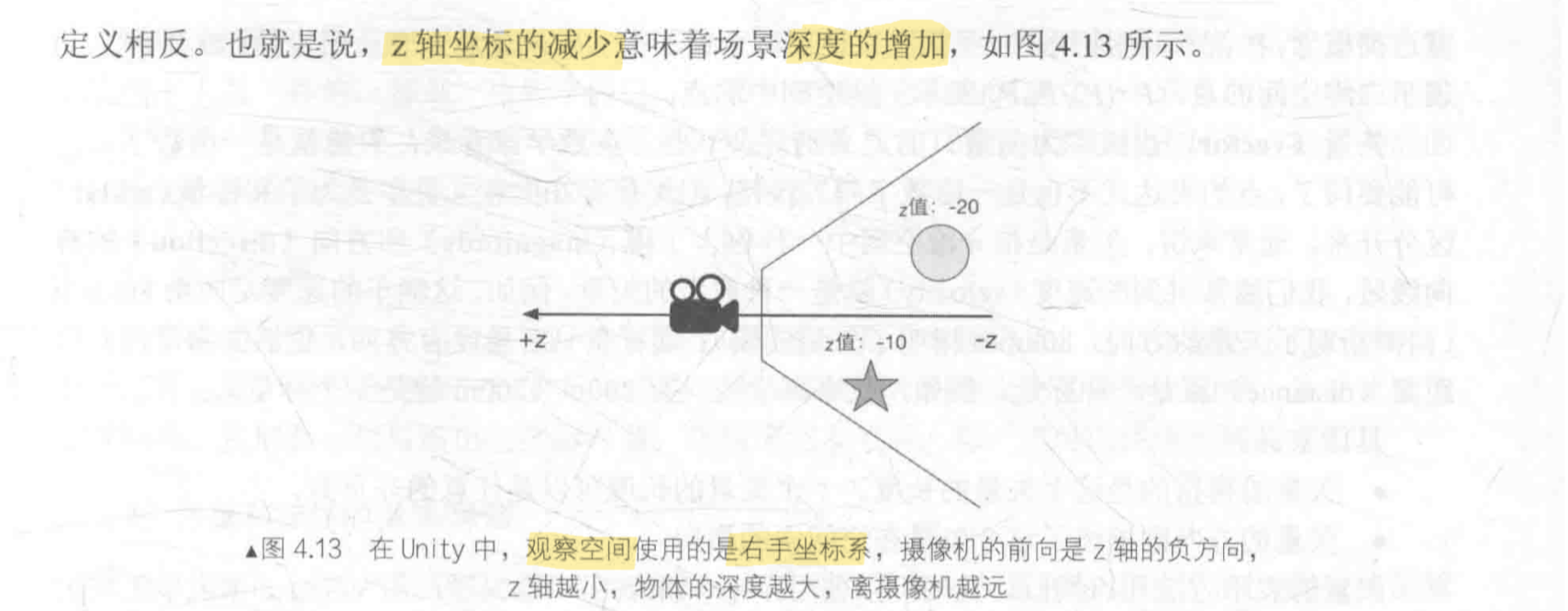

但是对于观察空间来说,Unity使用的是右手坐标系。

观察空间是以摄像机为原点的坐标系,摄像机的前向是z轴的负方向,z轴越小,物体深度越大,离摄像机月远。

4 - Unity Shader

4.1- 基本的Shader结构

4.1.1 - 基本Shader代码包含的内容

基本的一个Unlit Shader代码包含以下内容:

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

{

Properties

{

_MainTex ("Texture", 2D) = "white" {}

}

SubShader

{

Tags { "RenderType"="Opaque" }

LOD 100

Pass

{

CGPROGRAM

struct appdata

{

float4 vertex : POSITION;

float2 uv : TEXCOORD0;

};

struct v2f

{

float2 uv : TEXCOORD0;

float4 vertex : SV_POSITION;

};

sampler2D _MainTex;

float4 _MainTex_ST;

v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

return o;

}

fixed4 frag (v2f i) : SV_Target

{

// sample the texture

fixed4 col = tex2D(_MainTex, i.uv);

return col;

}

ENDCG

}

}

}

2

#pragma fragment frag他们将告诉Unity,哪个函数包含了顶点着色器的代码,哪个函数包含了片元着色器的代码。

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

{

float4 vertex : POSITION;

float2 uv : TEXCOORD0;

};

struct v2f

{

float2 uv : TEXCOORD0;

float4 vertex : SV_POSITION;

};

v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

return o;

}vert函数的输入v包含了这个顶点的位置和UV,他们是由POSITION和TEXCOORD0指定的,他们都是CG/HLSL中的语义。

POSITION告诉Unity,把模型的顶点坐标填充到appdata中的参数vertex中,SV_POSITION告诉Unity,v2f中的vertex就是裁剪空间中的顶点坐标。

v2f的含义是把顶点着色器的数据传输到片元着色器中:Vertex to Fragment。

2

3

4

5

6

{

// sample the texture

fixed4 col = tex2D(_MainTex, i.uv);

return col;

}

- 冒号(:)后面的**”SV_Target”表示此函数的返回值将被写入到指定的渲染目标(Render Target)中。在这种情况下,它指示将片段着色器(frag)的输出颜色写入到默认的渲染目标(通常是屏幕上的像素缓冲区)中。这里返回了一个表示纹理颜色的fixed4**类型的变量

- 在Unity的着色器中,片段着色器负责计算每个像素的颜色输出。通过使用**”SV_Target”**语义,我们可以指定将这个输出颜色写入到哪个渲染目标中,从而控制着色器的渲染结果在场景中的影响位置。

- 需要注意的是,这段代码中使用了默认的”SV_Target”语义,这意味着输出颜色将直接写入默认的渲染目标。在特定的渲染管线或自定义渲染流程中,可以使用其他语义来指定不同的渲染目标。

4.1.2 - 获取模型数据

我们可以使用纹理坐标来访问纹理,法线可以用于计算光照。

2

3

4

5

float4 vertex : POSITION;

float3 normal : NORMAL;

float4 texcoord : TEXCOORD0;

};通过声明一个新的结构体appdata,它包含了顶点着色器需要的模型数据。

对应顶点着色器的输出,Unity支持的语义有:POSITION, TANGENT , NORMAL,TEXCOORD0,TEXCOORD1, TEXCOORD2, TEXCOORD3,COLOR等

填充到POSITION、NORMAL、TEXCOORD0中的数据是由材质的Mesh Render组件提供的。

在调用Draw Call的时候,Mesh Render会将他负责渲染的模型数据发送给Unity Shader。

一个模型通常包含一组三角面片,每个三角面由3个顶点构成,而每个顶点又包含了一些数据,如:顶点位置、法线、切线、纹理位置、顶点颜色等。

4.1.3 - 顶点着色器与片元着色器之间的通信

2

3

4

5

{

float4 pos : SV_POSITION;

fixed3 color : COLOR0;

};v2f用于在顶点着色器与片元着色器之间传递信息。

我们使用了SV_POSITION和COLOR0语义,顶点着色器的输出结构中,必须包含一个变量,它的语义是SV_POSITION。COLOR0语义中的数据可以由用户自行定义,但一般都是存储颜色,例如逐顶点的漫反射颜色或逐顶点的高光反射颜色。类似的语义还有COLOR0。

顶点着色器是逐顶点调用的,而片元着色器是逐片元调用的,片元着色器的输入实际上是把顶点着色器的输入进行插值后得到的结果。

4.1.4 - 属性

Shader Lab中的属性类型和CG之间变量类型之间的匹配关系:

| Shader Lab属性类型 | CG变量类型 |

|---|---|

| Color,Vector | float4,half4,fixed4 |

| Range,Float | float,half,fixed |

| 2D | sample2D |

| Cube | sampleCube |

| 3D | sample3D |

4.2 - Unity内置文件和变量

为了方便开发,Unity提供了很多内置文件,包含许多提前定义的函数、变量、宏等。

例如:

我们可以前往官网下载,选择下载Built-in Shader。

以下是下载的Shader中CGIncludes文件夹中中主要包含的文件以及它们的主要用处:

| 文件名 | 描述 |

|---|---|

| UnityCG.cginc | 包含了最常使用的帮助函数、宏和结构体等 |

| UnityShader Variables.cginc | 在编译Unity Shader 时,会被自动包含进来。包含了许多内置的全局变量,如UNITY_MATRIX MVP等 |

| Lighting.cginc | 包含了各种内置的光照模型,如果编写的是Surface Shader的话,会自动包含进来 |

| HLSLSupport.cginc | 在编译Unity Shader时,会被自动包含进来。声明了很多用于跨平台编译的宏和定义 |

UnityCG.cginc是我们最常接触的文件,我们可以直接使用其中预定义的结构体作为顶点着色器的输入和输出。

| 名称 | 描述 | 包含的变量 |

|---|---|---|

| appdata_base | 可用于顶点着色器的输入 | 顶点位置、顶点法线、第一组纹理坐标 |

| appdata_tan | 可用于顶点着色器的输入 | 顶点位置、顶点切线、顶点法线、第一组纹理坐标 |

| appdata_full | 可用于顶点着色器的输入 | 顶点位置、顶点切线、顶点法线、四组(或更多)纹理坐标 |

| appdata_img | 可用于顶点着色器的输入 | 顶点位置、第一组纹理坐标 |

| v2f_img | 可用于顶点着色器的输出 | 裁剪空间中的位置、纹理坐标 |

UnityCG.cginc,还提供了许多常见的帮助函数以及用于访问时间、光照、雾效和环境光等目的的变量。

4.3 - Unity支持的语义

从应用阶段传递模型数据给顶点着色器时Unity支持的语义:

| 语义 | 描述 |

|---|---|

| POSITION | 模型空间中的顶点位置,通常是float4类型 |

| NORMAL | 顶点法线,通常是float3类型 |

| TANGENT | 顶点切线,通常是float4类型 |

| TEXCOORDn,如TEXCOORD0、TEXCOORD1 | 该顶点的纹理坐标,TEXCOORD0表示第一组纹理坐标,依此类推。通常是float2或float4类型 |

| COLOR | 顶点颜色,通常是 fixed4或float4类型 |

其中 TEXCOORDn 中n的数目是和 Shader Model有关的,例如一般在 Shader Model 2(即Unity默认编译到的Shader Model 版本)和Shader Model 3中,n等于8,而在Shader Model 4和Shader Model 5中,n等于16。通常情况下,一个模型的纹理坐标组数一般不超过2,即我们往往只使用TEXCOORDO和 TEXCOORD1。在Unity内置的数据结构体appdata_full 中,它最多使用了6个坐标纹理组。

从顶点着色器传递模型数据给片元着色器时Unity支持的语义:

| 语义 | 描述 |

|---|---|

| SV_POSITION | 裁剪空间中的顶点坐标,结构体中必须包含一个用该语义修饰的变量。等同于DirectX 9中的POSITION,但最好使用SV_POSITION |

| COLOR 0 | 通常用于输出第一组顶点颜色,但不是必需的 |

| COLOR 1 | 通常用于输出第二组顶点颜色,但不是必需的 |

| TEXCOORD0~TEXCOORD7 | 通常用于输出纹理坐标,但不是必需的 |

上面的语义中,除了SV_POSITION是有特别含义外,其他语义对变量的含义没有明确要求,

也就是说,我们可以存储任意值到这些语义描述变量中。通常,如果我们需要把一些自定义的数据从顶点着色器传递给片元着色器,一般选用TEXCOORDO等。

片元着色器输出时Unity支持的语义:

| 语义 | 描述 |

|---|---|

| SV_Target | 输出值将会存储到渲染目标(render target)中。等同于DirectX 9中的COLOR语义,但最好使用SV_Target |

需要注意的是,一个语义可以使用的寄存器只能处理4个浮点值(float)。因此,如果我们想要定义矩阵类型,如 float3×4、float4×4等变量就需要使用更多的空间。一种方法是,把这些变量拆分成多个变量,例如对于float4×4的矩阵类型,我们可以拆分成4个float4类型的变量,每个变量存储了矩阵中的一行数据。

4.4 - Debug

- 使用假彩色图片

- 使用Visual Studio中的Graphics Debugger

- 使用Unity中的帧调试器

4.4.1 - 帧调试器

Unity中的帧调试器可以让我们看到游戏图像中的某一帧是如何一步步渲染出来的。

可以从Window -> Analysis -> Frame Debugger打开帧调试器。

帧调试器可以用于查看渲染该帧时进行的各种渲染事件(event),这些事件包含了Draw Call序列,也包括了类似清空帧缓存等操作。帧调试器窗口大致可分为3个部分:最上面的区域可以开启/关闭(单击 Enable 按钮)帧调试功能,当开启了帧调试时,通过移动窗口最上方的滑动条(或单击前进和后退按钮),我们可以重放这些渲染事件;

左侧的区域显示了所有事件的树状图,在这个树状图中,每个叶子节点就是一个事件,而每个父节点的右侧显示了该节点下的事件数目。我们可以从事件的名字了解这个事件的操作,例如以 Draw开头的事件通常就是一个Draw Call;当单击了某个事件时,在右侧的窗口中就会显示出该事件的细节,例如几何图形的细节以及使用了哪个Shader等。同时在Game视图中我们也可以看到它的效果。如果该事件是一个 Draw Call并且对应了场景中的一个GameObject,那么这个GameObject也会在Hierarchy视图中被高亮显示出来。

如果被选中的Draw Call是对一个渲染纹理(RenderTexture)的渲染操作,那么这个渲染纹理就会显示在 Game视图中。而且,此时右侧面板上方的工具栏中也会出现更多的选项,例如在Game视图中单独显示R、G、B和A通道。

Unity提供的帧调试器实际上并没有实现一个真正的帧拾取(frame capture)功能,而是仅仅使用停止渲染的方法来查看渲染事件的结果。例如,如果我们想要查看第4个Draw Call 的结果,那么帧调试器就会在第4个 Draw Call 调用完毕后停止渲染。这种方法虽然简单,但得到的信息也很有限。如果想要获取更多的信息,还是需要使用外部工具,例如VisualStudio 插件,或者 Intel GPA、RenderDoc、NVIDIA NSight、AMD GPU PerfStudio等工具。

4.5 - 小心:渲染平台的差异

4.5.1 - 渲染纹理的坐标差异

OpenGL和DirectX的屏幕空间坐标存在差异,但是Unity会在背后为我们处理,翻转屏幕图像纹理,以达到在不同平台的一致性。

有一种情况下Unity不会为我们进行这个反转操作,这种情况是我们开启了抗锯齿。

在

Edit -> Project Settings -> Quality -> Anti Aliasing中开启

在这种种情况下,Unity 首先渲染得到屏幕图像,再由硬件进行抗锯齿处理后,得到一张渲染纹理来供我们进行后续处理。此时,在 DirectX平台下,我们得到的输入屏幕图像并不会被Unity翻转,也就是说,此时对屏幕图像的采样坐标是需要符合 DirectX平台规定的。如果我们的屏幕特效只需要处理一张渲染图像,我们仍然不需要在意纹理的翻转问题,这是因为在我们调用

Graphics.Blt函数时,Unity已经为我们对屏幕图像的采样坐标进行了处理,我们只需要按正常的采样过程处理屏幕图像即可。但如果我们需要同时处理多张渲染图像(前提是开启了抗锯齿),例如需要同时处理屏幕图像和法线纹理,这些图像在竖直方向的朝向就可能是不同的(只有在 DirectX这样的平台上才有这样的问题)。这种时候,我们就需要自己在顶点着色器中翻转某些渲染纹理(例如深度纹理或其他由脚本传递过来的纹理)的纵坐标,使之都符合DirectX平台的规则。例如:

2

3

4

if(_MainTex_TexelSize.y < 0)

uv.y= 1-uv.y;

#endif其中,UNITY_UV_STARTS_AT_TOP 用于判断当前平台是否是DirectX类型的平台,而当在这样的平台下开启了抗锯齿后,主纹理的纹素大小在竖直方向上会变成负值,以方便我们对主纹理进行正确的采样。因此,我们可以通过判断

MainTex_TexelSize.x是否小于0来检验是否开启了抗锯齿。如果是,我们就需要对除主纹理外的其他纹理的采样坐标进行竖直方向上的翻转。

在本书资源的项目中,我们开启了抗锯齿选项。在第12章中,我们将学习一些基本的屏幕后处理效果。这些效果大多使用了单张屏幕图像进行处理,因此我们不需要考虑平台差异化的问题,因为Unity已经在背后为我们处理过了。但在12.5节中,我们需要在一个Pass 中同时处理屏幕图像和提取得到的亮部图像来实现Bloom效果。由于需要同时处理多张纹理,因此在 DirectX这样的平台下如果开启了抗锯齿,主纹理和亮部纹理在竖直方向上的朝向就是不同的,我们就需要对亮部纹理的采样坐标进行翻转。在第13章中,我们需要同时处理屏幕图像和深度/法线纹理来实现一些特殊的屏幕效果,在这些处理过程中,我们也需要进行

一些平台差异化处理。在15.3节中,尽管我们也在一个 Pass中同时处理了屏幕图像、深度纹理和一张噪声纹理,但我们只对深度纹理的采样坐标进行了平台差异化处理,而没有对噪声纹理进行处理。这是因为,类似噪声纹理的装饰性纹理,它们在竖直方向上的朝向并不是很重要,即便翻转了效果往往也是正确的,因此我们可以不对这些纹理进行平台差异化处理。

除此之外,还有Shader语法和语义的差异。

4.5.2 - 语法差异

在表面着色器的顶点函数中,用了一个没有初始化的out修饰符参数

可以使用以下代码对这些参数进行初始化:

1

2

3

4

5void vert (inout appdata full v, out Input o){

//使用Unity内置的UNITY_INITIALIZE_OUTPUT宏对输出结构体o进行初始化

UNITY_INITIALIZE__OUTPUT ( Input, o);

//.…

}DirectX 9/11 不支持在顶点着色器中使用tex2D函数,因为在这个阶段Shader无法得到UV的偏导,而tex2D函数需要得到这个骗到,因此我们需要使用tex2Dlod函数来替代

1

tex2Dlod(tex, float4(uv, 0,0)).

4.5.3 - 语义差异

我们应该遵循以下语义来描述Shader的输入和输出变量

- 使用SV_POSITION来描述顶点着色器输出的顶点位置。一些Shader使用了 POSITION 语义,但这些Shader无法在索尼PS4平台上或使用了细分着色器的情况下正常工作。

- 使用SV_Target来描述片元着色器的输出颜色。一些Shader使用了COLOR或者COLOR0语义,同样的,这些Shader无法在索尼PS4上正常工作。

4.6 - Shader简洁之道

- 根据平台选择合适的精度

- 规范语法

- 避免不必要的计算

- 慎用分支和循环语句

- 不要除以0

4.6.1- 精度的选择

在CG/HLSL中,以下几种精度数值:

| 类型 | 精度 |

|---|---|

| float | 最高精度的浮点值。通常使用32位来存储 |

| half | 中等精度的浮点值。通常使用16位来存储,精度范围是-60000~+60 000 |

| fixed | 最低精度的浮点值。通常使用11位来存储,精度范围是-2.0~+2.0 |

- 大多数现代的桌面GPU 会把所有计算都按最高的浮点精度进行计算,也就是说,float、half、 fixed在这些平台上实际是等价的。这意味着,我们在PC上很难看出因为 half和fixed精度而带来的不同。

- 但在移动平台的GPU上,它们的确会有不同的精度范围,而且不同精度的浮点值的运算速度也会有所差异。因此,我们应该确保在真正的移动平台上验证我们的Shader 。

- fixed精度实际上只在一些较旧的移动平台上有用,在大多数现代的GPU上,它们内部把fixed和 half当成同等精度来对待。

尽管有上面的不同,但一个基本建议是,尽可能使用精度较低的类型,因为这可以优化 Shader的性能,这一点在移动平台上尤其重要。从它们大体的值域范围来看,我们可以使用fixed类型来存储颜色和单位矢量,如果要存储更大范围的数据可以选择half类型,最差情况下再选择使用float。如果我们的目标平台是移动平台,一定要确保在真实的手机上测试我们的Shader,这一点非常重要。

4.6.2 - 避免不必要的计算

当出现以下报错时:

或

出现这些错误信息大多是因为我们在Shader中进行了过多的运算,使得需要的临时寄存器数目或指令数目超过了当前可支持的数目。需要知道的是,不同的Shader Target、不同的着色器阶段,我们可使用的临时寄存器和指令数目都是不同的。

通常,我们可以通过指定更高等级的 Shader Target来消除这些错误。

| 指令 | 描述 |

|---|---|

| #pragma target 2.0 | 默认的 Shader Target等级。相当于Direct3D9上的Shader Model 2.0 |

| #pragma target 3.0 | 相当于 Direct3D 9上的 Shader Model 3.0 |

| #pragma target 4.0 | 相当于Direct3D 10上的Shader Model 4.0。目前只在 DirectX 11和 XboxOne/PS4平台上提供了 |

| #pragma target 5.0 | 相当于Direct3D 11上的Shader Model 5.0。目前只在 DirectX 11和XboxOne/PS4平台上提供了 |

需要注意的是,所有类似OpenGL 的平台(包括移动平台)被当成是支持到Shader Model 3.0的。而WP8/WinRT平台则只支持到Shader Model 2.0。

什么是 Shader Model 呢?

Shader Model是由微软提出的一套规范,通俗地理解就是它们决定了Shader中各个特性(feature)的能力(capability)。这些特性和能力体现在Shader能使用的运算指令数目、寄存器个数等各个方面。Shader Model等级越高,Shader的能力就越大。

虽然更高等级的Shader Target可以让我们使用更多的临时寄存器和运算指令,但一个更好的方法是尽可能减少Shader 中的运算,或者通过预计算的方式来提供更多的数据。

4.6.3- 慎用分支和循环语句

如果我们在Shader中使用了大量的流程控制语句,那么这个 Shader的性能可能会成倍下降。一个解决方法是,我们应该尽量把计算向流水线上端移动,例如把放在片元着色器中的计算放到顶点着色器中,或者直接在CPU中进行预计算,再把结果传递给Shader。当然,有时我们不可避免地要使用分支语句来进行运算,那么一些建议是:

- 分支判断语句中使用的条件变量最好是常数,即在Shader运行过程中不会发生变化;

- 每个分支中包含的操作指令数尽可能少;

- 分支的嵌套层数尽可能少。

5 - Unity 中的基础光照

如何决定一个像素的颜色,从宏观上看,渲染包含两大部分:

- 决定一个像素的可见性

- 决定这个像素上的光照计算

光照模型就是用于决定这个像素上的光照计算

5.1 - 模拟现实中的光照环境

要模拟真实的光照环境,需要考虑一下三种物理现象:

- 光线从光源中被发射出来

- 光线与场景中的物体相交,一部分被吸收,一部分被散射

- 摄像机吸收光线,产生了图像

5.1.1 - 光源

在光学中,我们使用辐照度(irradiance)来量化光。计算物体表明的辐照度可以使用光源方向l和表面法线n之间的夹角的余弦值来得到。

5.1.2 - 吸收和散射

光线由光源发射出来后,就会与一些物体相交。通常,相交的结果有两个:散射(scattering)和吸收(absorption)

散射只改变光线的方向,但不改变光线的密度和颜色。而吸收只改变光线的密度和颜色,但不改变光线的方向。

光线在物体表面经过散射后,有两种方向:一种将会散射到物体内部,这种现象被称为折射(refraction)或透射(transmission);另一种将会散射到外部,这种现象被称为**反射(reflection)**。

对于不透明物体,折射进入物体内部的光线还会继续与内部的颗粒进行相交,其中一些光线最后会重新发射出物体表面,而另一些则被物体吸收。那些从物体表面重新发射出的光线将具有和入射光线不同的方向分布和颜色。

为了区分两种不同的散射方向,我们在光照模型中使用了不同的部分来计算它们:高光反射(specular)部分表示物体表面是如何反射光线的,而漫反射(diffuse)部分则表示有多少光线会被折射、吸收和散射出表面。

5.1.3 - 着色

着色指的是根据材质属性、光源信息,使用一个等式去计算某个观察方向的出射度的过程,也成为光照模型。

5.1.3 - BRDF光照模型

当光线从某个点照射到一个表面时,有多少光线被反射,反射的方向有哪些,BRDF(Bidirectional Reflectance Distribution Function)光照模型就是用来回答这些问题的。

在图形学中,BRDF 大多使用一个数学公式来表示,并且提供了一些参数来调整材质属性。通俗来讲,当给定入射光线的方向和辐照度后,BRDF可以给出在某个出射方向上的

5.2 - 标准光照模型

5.2.1 - Phong光照模型

自发光:这个部分用于描述当给定一个方向时,一个表面本身会向该方向发射多少辐射量。

需要注意的是,如果没有使用**全局光照(global illumination)**技术,这些自发光的表面并不会真的照亮周围的物体,而是它本身看起来更亮了而已。

高光反射:这个部分用于描述当光线从光源照射到模型表面时,该表面会在完全镜面反射方向散射多少辐射量。

漫反射:这个部分用于描述,当光线从光源照射到模型表面时,该表面会向每个方向散射多少辐射量。

漫反射符合兰伯特定律:反射光线的强度与表面法线和光源方向之间的夹角的余弦值成正比

需要注意的是,我们需要防止法线和光源方向点乘的结果为负值,为此,我们使用取最大值的函数来将其截取到0,这可以防止物体被从后面来的光源照亮。

环境光:它用于描述其他所有的间接光照。

5.2.2 - Blinn-Phong光照模型

Blinn提出了简单的修改办法来得到类似的高光反射效果。在硬件实现时,如果摄像机和光源距离模型足够远的话,Blinn模型会快于Phong模型。

需要注意的是,这两种光照模型都是经验模型。

5.2.3 - 逐像素还是逐顶点光照

以上的光照模型可以在顶点着色器中计算,称为逐顶点光照(per-vertex lighting),也可以在片元着色器中计算,称为逐像素光照(per-pixel lighting)。

在逐像素光照中,我们会以每个像素为基础,得到它的法线(可以是对顶点法线插值得到的,也可以是从法线纹理中采样得到的),然后进行光照模型的计算。这种在面片之间对顶点法线进行插值的技术被称为Phong着色(Phong shading),也被称为Phong插值或法线插值着色技术。这不同于我们之前讲到的Phong光照模型。

与之相对的是逐顶点光照,也被称为高洛德着色(Gouraud shading)。在逐顶点光照中,我们在每个顶点上计算光照,然后会在渲染图元内部进行线性插值,最后输出成像素颜色。由于顶点数目往往远小于像素数目,因此逐顶点光照的计算量往往要小于逐像素光照。但是,由于逐顶点光照依赖于线性插值来得到像素光照,因此,当光照模型中有非线性的计算(例如计算高光反射时)时,逐顶点光照就会出问题。在后面的章节中,我们将会看到这种情况。而且,由于逐顶点光照会在渲染图元内部对顶点颜色进行插值,这会导致渲染图元内部的颜色总是暗于顶点处的最高颜色值,这在某些情况下会产生明显的棱角现象。

但这种模型有很多局限性。首先,有很多重要的物理现象无法用Blinn-Phong模型表现出来,例如菲涅耳反射(Fresnel reflection)。其次,Blinn-Phong模型是各项同性(isotropic)的,也就是说,当我们固定视角和光源方向旋转这个表面时,反射不会发生任何改变。但有些表面是具有各向异性(anisotropic)反射性质的,例如拉丝金属、毛发等。

5.3 - Unity中的环境光和自发光

在标准光照模型中,环境光和自发光的计算是最简单的。

- 在Unity 中,场景中的环境光可以在

Window ->Lighting ->Ambient SourcelAmbient ColorlAmbientIntensity中控制 - 在 Shader中,我们只需要通过Unity 的内置变量UNITY_LIGHTMODEL_AMBIENT就可以得到环境光的颜色和强度信息。

5.4 - 在Unity中实现漫反射光照模型

漫反射的计算公式:

$$

c_{diffuse} = (c_{light} \cdot m_{diffuse})max(0, \hat{n} \cdot I)

$$

从公式可以看出,要计算漫反射需要知道4个参数:

- 入射光线的颜色和强度c_light,

- 材质的漫反射系数m_diffuse,

- 表面法线n

- 光源方向I

为了防止点积结果为负值,我们需要使用max操作,而CG提供了这样的函数。在本例中,使用CG的另一个函数可以达到同样的目的,即

saturate函数。

5.4.1 - 逐顶点光照的实现

为Shader改名

为了得到漫反射颜色,声明Color类型的属性**_Diffuse**,用于控制漫反射颜色

1

2

3

4Properties

{

_Diffuse ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

}在Pass中指定光照模式

1

Tags { "LightMode" = "ForwardBase" }

包含Unity内置文件Lighting.cginc

定义变量,与属性中声明的变量匹配

在appdata和v2f中定义相应的变量

1

2

3

4

5

6

7

8

9

10

11struct appdata

{

float4 vertex : POSITION;

fixed3 normal : NORMAL;

};

struct v2f

{

float4 vertex : SV_POSITION;

fixed3 color : COLOR;

};在顶点着色计算漫反射

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

// 获取环境光

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(mul(v.normal, (float3x3)unity_WorldToObject));

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

// 计算漫反射

fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * saturate(dot(worldNormal,worldLight));

o.color = ambient + diffuse;

return o;

}因为计算都在顶点着色器中完成,片元着色器只要返回颜色值。

1

2

3

4fixed4 frag (v2f i) : SV_Target

{

return fixed4(i.color, 1.0);

}最后添加回调函数

1

FallBack "Diffuse"

5.4.2 - 逐像素光照的实现

逐像素光照是在逐顶点光照的基础上,将计算都移到片元着色器中实现。

顶点着色器和片元着色器的输入:

2

3

4

5

6

7

8

9

10

11

{

float4 vertex : POSITION;

fixed3 normal : NORMAL;

};

struct v2f

{

float4 vertex : SV_POSITION;

float3 worldNormal : TEXCOORD0;

};

顶点着色器中只计算法线方向

2

3

4

5

6

7

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = mul(v.normal, (float3x3)unity_WorldToObject);

return o;

}

在片元着色器中完成所有计算:

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

{

// 获取环境光

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(i.worldNormal);

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

// 计算漫反射

fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * saturate(dot(worldNormal,worldLight));

fixed3 color = ambient + diffuse;

return fixed4(color, 1.0);

}

5.4.3 - 半兰伯特模型

半兰伯特模型的计算公式如下:

$$

c_{diffuse} = (c_{light} \cdot m_{diffuse})(0.5(0, \hat{n} \cdot I)+0.5)

$$

这个模型没有使用Max函数来防止光线为负,而是将n·I的结果从[-1,1]映射到[0,1]的范围。

这样做的好处是能够使得背光面有明暗变化,而不是死黑。

在逐像素光照的基础上,将saturate的操作更换成以下操作

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

{

// 获取环境光

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(i.worldNormal);

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

// 计算漫反射

fixed halfLambert = dot(worldNormal,worldLight) * 0.5 + 0.5;

fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * halfLambert;

fixed3 color = ambient + diffuse;

return fixed4(color, 1.0);

}

5.5 - 在Unity中实现高光反射模型

高光反射的计算公式如下:

$$

c_{specular} = (c_{light} \cdot m_{specular})max(0, \hat{v} \cdot r)^{m_{gloss}}

$$

从上述公式可以得出,计算高光反射需要4个参数:

- 入射光线的颜色和强度c_light

- 材质的高光反射系数m_specular

- 视角方向的单位向量v

- 反射方向r

反射方向r可以由表面法线的单位向量n和光源方向的单位向量I得到,

可以直接使用CG提供的函数

reflect(i,n)计算得出

5.5.1 - 逐顶点光照的实现

首先,在属性声明三个属性:

1

2

3

4

5

6

7Properties

{

_Diffuse ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

_Specular ("Specular", Color) = (1.0, 1.0, 1.0, 1.0)

_Gloss ("", Range(8.0, 256)) = 20

//高光区域大小

}其中,Specular用于控制高光反射的颜色,Gloss用于控制高光区域的大小

然后指明光照模式

1

Tags { "LightMode" = "ForwardBase" }

指明我们定义的顶点和片元着色器,同时将

"Lighting.cginc"包含进来声明属性变量,并且定义顶点和片元着色器的输入结构体

1

2

3

4

5

6

7

8

9

10

11struct appdata

{

float4 vertex : POSITION;

fixed3 normal : NORMAL;

};

struct v2f

{

float4 vertex : SV_POSITION;

float3 color : COLOR;

};在顶点着色器中计算高光反射:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

// 获取环境光

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(mul(v.normal, (float3x3)unity_WorldToObject));

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

//计算漫反射系数

fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * saturate(dot(worldNormal,worldLight));

//从世界空间获取反射方向

fixed3 reflectDir = normalize(reflect(-worldLight, worldNormal));

//从世界空间获取视觉方向

fixed3 viewDir = normalize(_WorldSpaceCameraPos.xyz - mul(unity_ObjectToWorld, v.vertex).xyz);

//计算高光系数

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(saturate(dot(reflectDir, viewDir)),_Gloss);

o.color = ambient + diffuse + specular;

return o;

}漫反射的部分和上节提到的完全一致,对于高光反射部分,我们首先计算入射光线方向关于表面法线的反射方向reflectDir。由于CG的reflect函数的入射方向要求是由光源指向交点处的,因此我们需要对 worldLightDir 取反后再传给reflect函数。

然后,我们通过**_WorldSpaceCameraPos得到了世界空间中的摄像机位置,再把顶点位置从模型空间变换到世界空间下,再通过和_WorldSpaceCameraPos** 相减即可得到世界空间下的视角方向。

在片元着色器中输出颜色

1

2

3

4fixed4 frag (v2f i) : SV_Target

{

return fixed4(i.color, 1.0);

}最后设置回调函数

1

FallBack "Specular"

5.5.2 - 逐像素光照的实现

在逐顶点光照的基础上,修改输入结构体:

1

2

3

4

5

6

7

8

9

10

11

12struct appdata

{

float4 vertex : POSITION;

fixed3 normal : NORMAL;

};

struct v2f

{

float4 vertex : SV_POSITION;

float3 worldNormal : TEXCOORD0;

float3 worldPos : TEXCOORD1;

};在顶点着色器中,我们只要计算世界空间下的法线方向以及顶点坐标,并将它们传递给片元着色器即可

1

2

3

4

5

6

7

8v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = mul(v.normal, (float3x3)unity_WorldToObject);

o.worldPos = mul(unity_ObjectToWorld, v.vertex);

return o;

}在片元着色器中计算光照模型:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25fixed4 frag (v2f i) : SV_Target

{

// 获取环境光

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(i.worldNormal);

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

//计算漫反射系数

fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * saturate(dot(worldNormal,worldLight));

//从世界空间获取反射方向

fixed3 reflectDir = normalize(reflect(-worldLight, worldNormal));

//从世界空间获取视觉方向

fixed3 viewDir = normalize(_WorldSpaceCameraPos.xyz - i.worldPos.xyz);

//计算高光系数

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(saturate(dot(reflectDir, viewDir)),_Gloss);

fixed3 color = ambient + diffuse + specular;

return fixed4(color, 1.0);

}在从世界空间获取反射方向r中,CG的reflect函数的入射方向要求是由光源指向交点处的,因此我们需要对 worldLightDir 取反后再传给reflect函数。

逐像素处理可以得到更加平滑的高光效果,至此,我们得到了一个完整的Phong光照模型

5.5.3 - Blinn-Phong光照模型

Blinn模型没有使用反射方向r,而是引入一个新的矢量h:

$$

\hat{h} = \frac{\hat{v} + \hat{I}}{\mid \hat{v} + \hat{I} \mid }

$$

而Blinn模型计算高光反射的公式如下:

$$

c_{specular} = (c_{light} \cdot m_{specular})max(0, \hat{n} \cdot \hat{h})^{m_{gloss}}

$$

代码的实现只要修改逐像素光照中片元着色器的部分:

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

{

...

//从世界空间获取视觉方向

fixed3 viewDir = normalize(_WorldSpaceCameraPos.xyz - i.worldPos.xyz);

//从世界空间获取半方向

fixed3 halfDir = normalize(worldLight + viewDir);

//计算高光系数

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0,dot(worldNormal, halfDir)),_Gloss);

fixed3 color = ambient + diffuse + specular;

return fixed4(color, 1.0);

}使用法线向量n与halfDir进行点积,最后将环境光、漫反射、高光反射相加得到颜色。

Blinn-Phong光照模型的高光反射部分看起来更大、更亮一些,在实际的渲染中,我们也会选择Blinn-Phong光照模型。

5.6 - Unity内置函数

在计算光照模型的时候,我们往往需要得到光源方向、视角方向这两个基本信息。我们在上面的例子中得到的光源方向,这种办法只适用于平行光,如果需要处理更复杂的光照模型,如点光源和聚光灯,那么这种计算方法是错误的。我们需要现在代码中先判断光源的类型,再计算它的光源信息。

Unity提供了一些内置函数来帮助我们计算这些信息:

| 函数名 | 描述 |

|---|---|

| float3 WorldSpaceViewDir (float4 v) | 输入一个模型空间中的顶点位置,返回世界空间中从该点到摄像机的观察方向。内部实现使用了Unity WorldSpace ViewDir函数 |

| float3 Unity WorldSpaceViewDir (float4 v) | 输入一个世界空间中的顶点位置,返回世界空间中从该点到摄像机的观察方向 |

| float3 ObjSpaceViewDir (float4 v) | 输入一个模型空间中的顶点位置,返回模型空间中从该点到摄像机的观察方向 |

| float3 WorldSpaceLightDir(float4 v) | 仅可用于前向渲染中。输入一个模型空间中的顶点位置,返回世界空间中从该点到光源的光照方向。内部实现使用了 Unity WorldSpaceLightDir函数。没有被归一化 |

| float3 UnityWorldSpaceLightDir (float4 v) | 仅可用于前向渲染中。输入一个世界空间中的顶点位置,返回世界空间中从该点到光源的光照方向。没有被归一化 |

| float3 ObjSpaceLightDir (float4 v) | 仅可用于前向渲染中。输入一个模型空间中的顶点位置,返回模型空间中从该点到光源的光照方向。没有被归一化 |

| float3 UnityObjectToWorldNormal (float3 norm) | 把法线方向从模型空间转换到世界空间中 |

| float3 UnityObjectToWorldDir (in float3 dir) | 把方向矢量从模型空间变换到世界空间中 |

| float3 Unity WorldToObjectDir(float3 dir) | 把方向矢量从世界空间变换到模型空间中 |

需要注意的是,这些函数都没有保障得到的方向矢量是单位矢量,因此,我们需要在使用前把它们归一化

计算光源方向的3个函数:

- WorldSpaceLightDir

- Unity WorldSpaceLightDir

- ObjSpaceLightDir

它们尽可用于向前渲染,因为只有在向前渲染中,这3个函数中使用的内置变量**_WorldSpaceLightPos0**才会被正确赋值。

以下是在Blinn-Phong光照模型中的使用Unity内置函数的例子:

在顶点着色器中,我们使用UnityObjectToWorldNormal 来计算世界空间下的法线方向

1

2

3

4

5

6

7

8

9

10

11v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

//o.worldNormal = mul(v.normal, (float3x3)unity_WorldToObject);

//使用内置函数来计算世界空间中的法线向量

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.worldPos = mul(unity_ObjectToWorld, v.vertex);

return o;

}在片元着色器中,我们使用内置的UnityWorldSpaceLightDir 函数和WorldSpaceViewDir 来计算世界空间中的光照方向和视角方向

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19fixed4 frag (v2f i) : SV_Target

{

...

// 将法线方向从物体空间转为剪裁空间

fixed3 worldNormal = normalize(i.worldNormal);

// 获取世界空间下的光线方向

fixed3 worldLight = normalize(UnityWorldSpaceLightDir(i.worldPos));

//fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

...

...

//从世界空间获取视角方向

fixed3 viewDir = normalize(UnityWorldSpaceViewDir(i.worldPos));

//fixed3 viewDir = normalize(_WorldSpaceCameraPos.xyz - i.worldPos.xyz);

...

}

以上的方向矢量都需要使用normalize进行归一化得到单位矢量。

6 - 基础纹理

在美术人员建模的时候,通常会在建模软件中利用纹理展开技术把纹理映射坐标(texture-mapping coordinates)存储在每个顶点上。纹理映射坐标定义了该顶点在纹理中对应的2D坐标。通常,这些坐标使用一个二维变量(u, v)来表示,其中u是横向坐标,而v是纵向坐标。因此,纹理映射坐标也被称为UV坐标。

Unity使用的纹理空间是符合OpenGL风格的。

6.1 - 单张纹理

6.1.1 - 单张纹理的实现

为了使用纹理,在Properties中添加以下属性

1

2

3

4

5

6

7Properties

{

_Color ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

_MainTex ("Texture", 2D) = "white" {}

_Specular ("Specular", Color) = (1.0, 1.0, 1.0, 1.0)

_Gloss ("", Range(8.0, 256)) = 20

}指明光照模式、声明变量、包含内置文件

与其他属性类型不同的是,我们还需要为纹理类型的属性声明一个 float4类型的变量**_MainTex_ST。其中,_MainTex_ST的名字不是任意起的。在 Unity中,我们需要使用纹理名_ST的方式来声明某个纹理的属性。其中,ST是缩放(scale)和平移( translation)的缩写。_MainTex_ST可以让我们得到该纹理的缩放和平移(偏移)值,_MainTex_ST.xy** 存储的是缩放值,而**_MainTex ST.zw**存储的是偏移值。这些值可以在材质中调节。

定义顶点着色器的输入和输出结构体

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15struct appdata

{

float4 vertex : POSITION;

fixed3 normal : NORMAL;

float2 uv : TEXCOORD0;

};

struct v2f

{

float4 vertex : SV_POSITION;

float2 uv : TEXCOORD2;

float3 worldNormal : TEXCOORD0;

float3 worldPos : TEXCOORD1;

};在上面的代码中,我们首先在a2v结构体中使用TEXCOORDO语义声明了一个新的变量uv,这样Unity就会将模型的第一组纹理坐标存储到该变量中。

然后,我们在v2f结构体中添加了用于存储纹理坐标的变量uv,以便在片元着色器中使用该坐标进行纹理采样。

定义顶点着色器

1

2

3

4

5

6

7

8

9

10

11

12v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.worldPos = mul(unity_ObjectToWorld, v.vertex).xyz;

o.uv = TRANSFORM_TEX(v.uv, _MainTex);

return o;

}在顶点着色器中,我们使用纹理的属性值**_MainTex_ST来对顶点纹理坐标进行变换,得到最终的纹理坐标。计算过程是,首先使用缩放属性_MainTex_ST.xy** 对顶点纹理坐标进行缩放,然后再使用偏移属性_Main Tex_ST.zw对结果进行偏移。

Unity 提供了一个内置宏 TRANSFORM_TEX来帮我们计算上述过程。TRANSFORM_TEX是在 UnityCGcginc中定义的:

1

#define TRANSFORM_TEX(tex, name) {tex.xy * name##_ST,xy + name##_ST,zw}

实现片元着色器,并在计算漫反射时使用纹理中的纹素值

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18fixed4 frag (v2f i) : SV_Target

{

fixed3 worldNormal = normalize(i.worldNormal);

fixed3 worldLightDir = normalize(UnityWorldSpaceLightDir(i.worldPos));

fixed3 albedo = tex2D(_MainTex, i.uv).rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(worldNormal, worldLightDir));

fixed3 viewDir = normalize(UnityWorldSpaceViewDir(i.worldPos));

fixed3 halfDir = normalize(worldLightDir + viewDir);

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0,dot(worldNormal, halfDir)),_Gloss);

fixed3 col = ambient + diffuse + specular;

return fixed4(col, 1.0);

}上面的代码首先计算了在世界空间下的法线方向和光照方向,然后使用CG的tex2D函数对纹理进行采样。它的第一个参数是需要被采样的纹理,第二个参数是一个float2类型的纹理坐标,它将返回计算得到的纹素值。我们使用采样结果和颜色属性**_Color** 的乘积来作为材质的反射率albedo,并把它和环境光照相乘得到环境光部分。随后,我们使用albedo来计算漫反射光照的结果,并和环境光照、高光反射光照相加后返回。

设置合适的回调函数

1

FallBack "Specular"

6.1.2 - 纹理的属性

纹理的类型有以下几种

- Default:默认为纹理类型

- Normal map:法线类型

- Cubemap

Wrap Mode一共有两种: Repeat和Clamp。它决定了纹理坐标超过[0, 1]时候纹理将会如何被平铺,Repeat会不断重复,Clamp只会截取临近的部分,如果纹理坐标大于1,那么会截取到1,如果小于0,那么会截取到0;

Filter Mode:它决定了当纹理由于变换而产生拉伸时将会采用哪种滤波模式。

Filter Mode支持3种模式:Point,Bilinear以及 Trilinear。它们得到的图片滤波效果依次提升,但需要耗费的性能也依次增大。纹理滤波会影响放大或缩小纹理时得到的图。

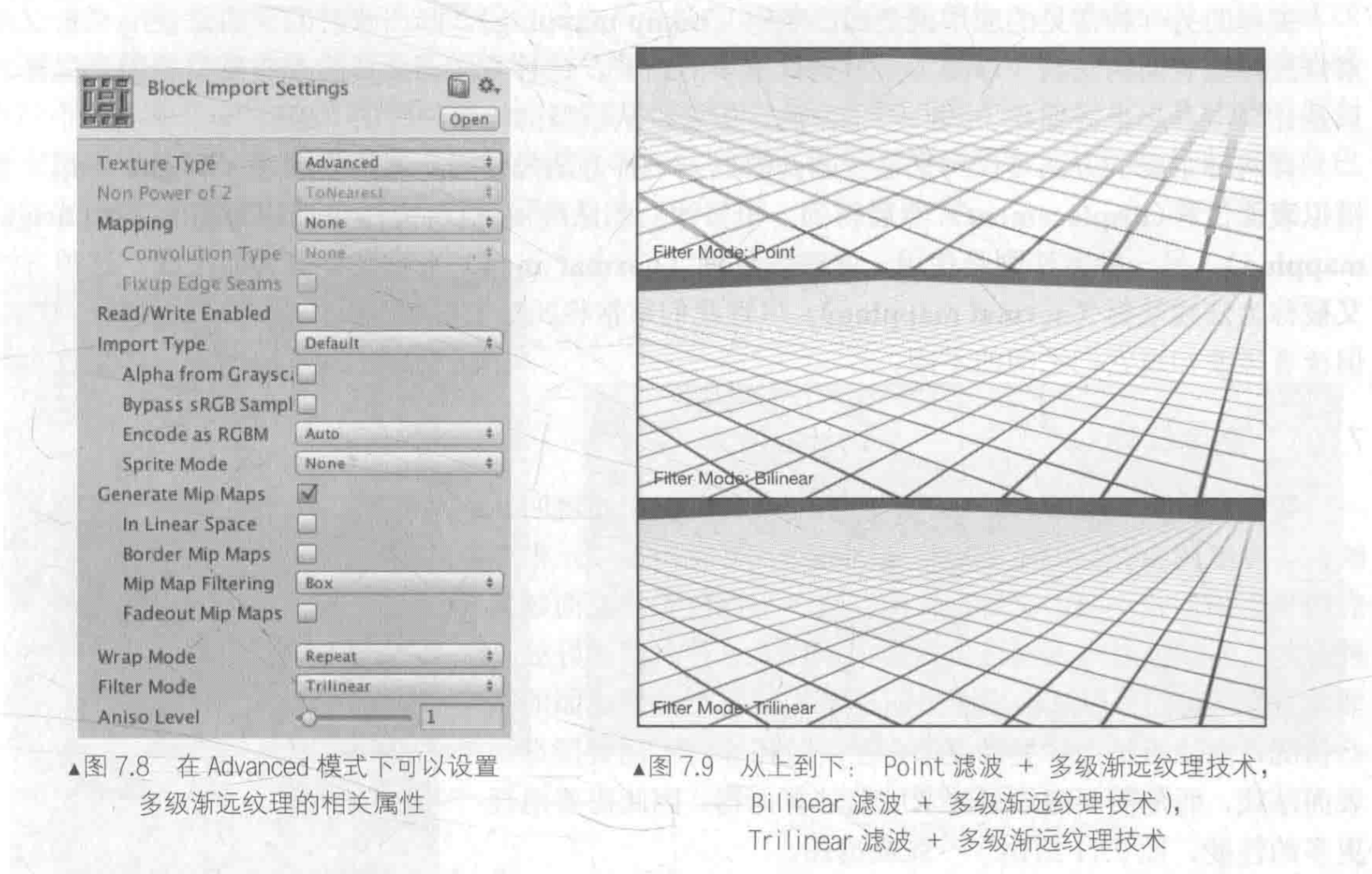

纹理缩小的过程比放大更加复杂一些,此时原纹理中的多个像素将会对应一个目标像素。纹理缩放更加复杂的原因在于我们往往需要处理抗锯齿问题一个最常使用的方法就是使用多级渐远纹理(mipmapping)技术。

多级渐远纹理技术将原纹理提前用滤波处理来得到很多更小的图像,形成了一个图像金字塔,每一层都是对上一层图像降采样的结果。这样在实时运行时,就可以快速得到结果像素,例如当物体远离摄像机时,可以直接使用较小的纹理。但缺点是需要使用一定的空间用于存储这些多级渐远纹理,通常会多占用33%的内存空间。这是一种典型的用空间换取时间的方法。

在 Unity中,我们可以在纹理导入面板中,首先将纹理类型(TextureType)选择成Advanced,再勾选 Generate Mip Maps即可开启多级渐远纹理技术。同时,我们还可以选择生成多级渐远纹理时是否使用线性空间以及采用的滤波器等。

在内部实现上,Point模式使用了最近邻(nearest neighbor)滤波,在放大或缩小时,它的采样像素数目通常只有一个,因此图像会看起来有种像素风格的效果。而Bilinear滤波则使用了线性滤波,对于每个目标像素,它会找到4个邻近像素,然后对它们进行线性插值混合后得到最终像素,因此图像看起来像被模糊了。而 Trilinear滤波几乎是和 Bilinear一样的,只是 Trilinear还会在多级渐远纹理之间进行混合。如果一张纹理没有使用多级渐远纹理技术,那么Trilinear得到的结果还是和Bilinear是一样的。

纹理的最大尺寸:如果导入的纹理大小超过了Max Texture Size 中的设置值,那么Unity将会把该纹理缩放为这个最大分辨率。理想情况下,导入的纹理可以是非正方形的,但长宽的大小应该是2的幂,

例如

2、4、8、16、32、64等。如果使用了非2的幂大小(Non Powerof Two,NPOT)的纹理,那么这些纹理往往会占用更多的内存空间,而且GPU 读取该纹理的速度也会有所下降。有一些平台甚至不支持这种NPOT纹理,这时Unity在内部会把它缩放成最近的2的幂大小。出于性能和空间的考虑,我们应该尽量使用2的幂大小的纹理。

Point,Bilinear以及 Trilinear下的画面拉伸的图:

6.2 - 凹凸映射

纹理的另一种常见的应用就是凹凸映射(bump mapping)。凹凸映射的目的是使用一张纹理来修改模型表面的法线,以便为模型提供更多的细节。这种方法不会真的改变模型的顶点位置,只是让模型看起来好像是“凹凸不平”的,但可以从模型的轮廓处看出“破绽”。

有两种主要的方法可以用来进行凹凸映射:

- 一种方法是使用一张高度纹理(height map)来模拟表面位移(displacement),然后得到一个修改后的法线值,这种方法也被称为高度映射(heightmapping);

- 另一种方法则是使用一张法线纹理(normal map)来直接存储表面法线,这种方法又被称为法线映射(normal mapping)。尽管我们常常将凹凸映射和法线映射当成是相同的技术,但读者需要知道它们之间的不同。

6.2.1 - 高度纹理

高度图中存储的是强度值(intensity),它用于表示模型表面局部的海拔高度。因此,颜色越浅表明该位置的表面越向外凸起,而颜色越深表明该位置越问里。

这种力云内灯处足非常直观,我们可以从高度图中明确地知道一个模型表画的凹凸情况,但缺点是计算更加复杂,在实时计算时不能直接得到表面法线,而是需要由像素的灰度值,因此需要消耗更多的性能。

高度图通常会和法线映射一起便用,用于给出表面凹凸的额外信息。也就是说,我们通常会使用法线映射来修改光照。

6.2.2 - 法线纹理

而法线纹理中存储的就是表面的法线方向。由于法线方向的分量范围在**[-1,1],而像素的分量范围为[0,1],因此我们需要做一个映射,通常使用的映射就是:

$$

pixel = \frac{normal + 1}{2}

$$

这就要求,我们在Shader中对法线纹理进行纹理采样后,还需要对结果进行一次反映射的过程,以得到原先的法线方向。反映射的过程实际就是使用上面映射函数的逆函数:

$$

normal = pixel * 2 -1

$$

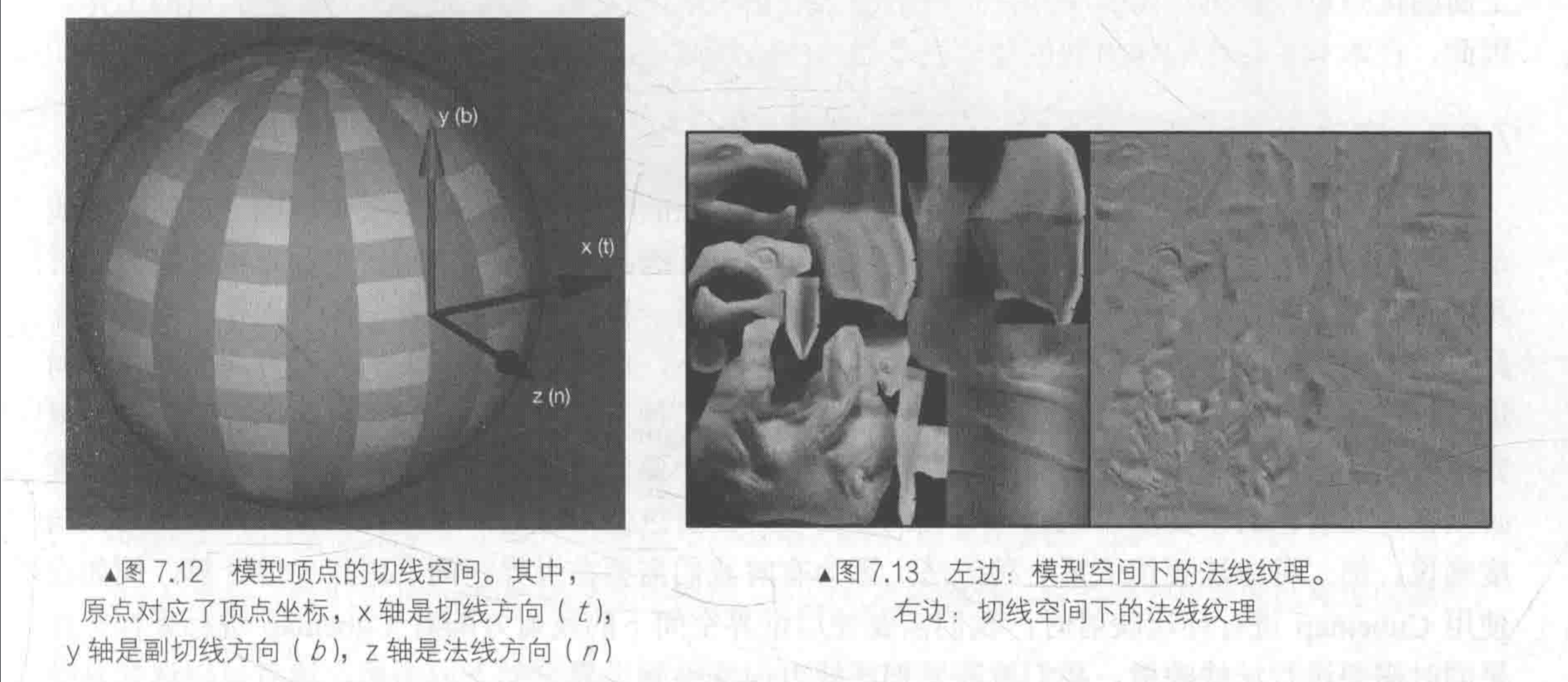

在实际制作中,我们往往会采用另一种坐标空间,即模型顶点的切线空间**(tangent space)来存储法线。

对于模型的每个顶点,它都有一个属于自己的切线空间,这个切线空间的原点就是该顶点本身,而z轴是顶点的法线方向(n),x轴是顶点的切线方向(t),而y轴可由法线和切线叉积而得,也被称为是副切线(bitangent,b)或副法线,如图7.12所示。

总体来说,使用模型空间来存储法线的优点如下。

- 实现简单,更加直观。我们甚至都不需要模型原始的法线和切线等信息,也就是说,计算更少。生成它也非常简单,而如果要生成切线空间下的法线纹理,由于模型的切线一般是和UV方向相同,因此想要得到效果比较好的法线映射就要求纹理映射也是连续的。

- 在纹理坐标的缝合处和尖锐的边角部分,可见的突变(缝隙)较少,即可以提供平滑的边界。这是因为模型空间下的法线纹理存储的是同一坐标系下的法线信息,因此在边界处通过插值得到的法线可以平滑变换。而切线空间下的法线纹理中的法线信息是依靠纹理坐标的方向得到的结果,可能会在边缘处或尖锐的部分造成更多可见的缝合迹象。

但使用切线空间有更多优点。

- 自由度很高。模型空间下的法线纹理记录的是绝对法线信息,仅可用于创建它时的那个模型,而应用到其他模型上效果就完全错误了。而切线空间下的法线纹理记录的是相对法线信息,这意味着,即便把该纹理应用到一个完全不同的网格上,也可以得到一个合理的结果。

- 可进行UV动画。比如,我们可以移动一个纹理的UV坐标来实现一个凹凸移动的效果,但使用模型空间下的法线纹理会得到完全错误的结果。原因同上。这种UV动画在水或者火山眯岩这种类型的物体上会经常用到。

- 可以重用法线纹理。比如,一个砖块,我们仅使用一张法线纹理就可以用到所有的6个面上。原因同上。

- 可压缩。由于切线空间下的法线纹理中法线的Z方向总是正方向,因此我们可以仅存储XY方向,而推导得到Z方向。而模型空间下的法线纹理由于每个方向都是可能的,因此必须存储3个方向的值,不可压缩。

切线空间下的法线纹理的前两个优点足以让很多人放弃模型空间下的法线纹理而选择它。从上面的优点可以看出,切线空间在很多情况下都优于模型空间,而且可以节省美术人员的工作。因此,在本书中,我们使用的也是切线空间下的法线纹理。

我们需要在计算光照模型中统一各个方向矢量所在的坐标空间。由于法线纹理中存储的法线是切线空间下的方向,因此我们通常有两种选择:

- 一种选择是在切线空间下进行光照计算,此时我们需要把光照方向、视角方向变换到切线空间下;

- 另一种选择是在世界空间下进行光照计算,此时我们需要把采样得到的法线方向变换到世界空间下,再和世界空间下的光照方向和视角方向进行计算。

从效率上来说,第一种方法往往要优于第二种方法,因为我们可以在顶点着色器中就完成对光照方向和视角方向的变换,而第二种方法由于要先对法线纹理进行采样,所以变换过程必须在片元着色器中实现,这意味着我们需要在片元着色器中进行一次矩阵操作。

但从通用性角度来说,第二种方法要优于第一种方法,因为有时我们需要在世界空间下进行一些计算,例如在使用 Cubemap进行环境映射时,我们需要使用世界空间下的反射方向对Cubemap进行采样。如果同时需要进行法线映射,我们就需要把法线方向变换到世界空间下。

6.2.3 - 在切线空间下计算

基本思路:

在顶点着色器中把视角方向和光照方向从模型空间变换到切线空间中

我们需要知道从模型空间到切线空间的变换矩阵,这个变换矩阵的逆矩阵即从切线空间到模型空间的变换矩阵是非常容易求得的。如果一个变换中仅存在平移和旋转变换,那么这个变换的逆矩阵就等于它的转置矩阵,而从模型空间到切线空间的变换矩阵就是从切线空间到模型空间的变换矩阵的转置矩阵。

在片元着色器中通过纹理采样得到切线空间下的法线,然后再与切线空间下的视角方向、光源方向等计算

实现如下:

添加属性

1

2

3

4

5

6

7

8

9Properties

{

_MainTex ("Texture", 2D) = "white" {}

_Color ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

_Specular ("Specular", Color) = (1.0, 1.0, 1.0, 1.0)

_Gloss ("", Range(8.0, 256)) = 20

_BumpMap ("BumpMap", 2D) = "Bump" {}

_BumpScale ("BumpScale", Float) = 1.0

}其中,**_Color、_Specular、_Gloss**都是我们为了实现之前的Blinn-Phong光照模型所需的必要参数

_BumpMap是我们需要的法线纹理,**_BumpScale**用于控制纹理的凹凸程度

配置光照模式、声明变量、引入内置文件

修改顶点着色器的输入结构体

1

2

3

4

5

6

7struct appdata

{

float4 vertex : POSITION;

float3 normal : NORMAL;

float4 tangent : TANGENT;

float4 uv : TEXCOORD0;

};我们使用TANGENT语义来描述tangent,即告诉Unity把顶点的切线方向填充到tangent中

需要注意的是,和法线方向normal 不同,tangent的类型是float4,而非 float3,这是因为我们需要使用tangent.w分量来决定切线空间中的第三个坐标轴——副切线的方向性。

修改片元着色器的输入结构体

1

2

3

4

5

6

7struct v2f

{

float4 vertex : SV_POSITION;

float4 uv : TEXCOORD0;

float3 lightDir : TEXCOORD1;

float3 viewDir : TEXCOORD2;

};定义顶点着色器

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

//为了减少寄存器的使用,将贴图存储到一个纹理坐标中

o.uv.xy = v.uv.xy * _MainTex_ST.xy + _MainTex_ST.zw;

o.uv.zw = v.uv.xy * _BumpMap_ST.xy + _BumpMap_ST.zw;

// o.uv.xy = TRANSFORM_TEX(v.uv.xy, _MainTex);

// o.uv.zw = TRANSFORM_TEX(v.uv.xy, _BumpMap);

TANGENT_SPACE_ROTATION;

o.lightDir = mul(rotation, ObjSpaceLightDir(v.vertex)).xyz;

o.viewDir = mul(rotation, ObjSpaceViewDir(v.vertex)).xyz;

return o;

}由于我们使用了两张纹理,我们使用float4类型的 uv去保存它们,其中xy分量存储**_Main的Tex纹理坐标,zw分量存储_BumpMap**纹理坐标。这样做的好处是可以减少插值寄存器的使用数目。

然后我们使用Unity内置的宏来计算得到从模型空间到切线空间的变换矩阵 rotation

然后,我们使用Unity的内置函数ObjSpaceLightDir和ObjSpaceViewDir来得到模型空间下的光照和视角方向,再使用变换矩阵将它们从模型空间变换到切线空间中。

我们在顶点着色器中完成了大部分工作,在片元着色器中只需要采样得到切线空间下的法线方向,再在切线空间下进行光照计算即可

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24fixed4 frag (v2f i) : SV_Target

{

fixed3 tangentLightDir = normalize(i.lightDir);

fixed3 tangentViewDir = normalize(i.viewDir);

fixed4 packedNormal = tex2D(_BumpMap, i.uv.zw);

fixed3 tangentNormal;

tangentNormal = UnpackNormal(packedNormal);

tangentNormal.xy *= _BumpScale;

tangentNormal.z = sqrt(1.0 - saturate(dot(tangentNormal.xy, tangentNormal.xy)));

fixed3 albedo = tex2D(_MainTex, i.uv).rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(tangentNormal, tangentLightDir));

fixed3 halfDir = normalize(tangentLightDir + tangentViewDir);

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0, dot(tangentNormal, halfDir)), _Gloss);

return fixed4(ambient + diffuse + specular, 1.0);

}我们先用tex2D对法线纹理**_BumpMap**进行采样。因为法线纹理中存储的是把法线经过映射得到的像素值,因此我们需要把它们反映射回来。

我们需要在Unity中把这个法线纹理设置为Normal map,然后只用Unity的内置函数UnpackNormal来获得正确的法线方向。

使用**_BumpScale对法线的值进行缩放,由于法线都是单位矢量,因此tangentNormal.z分量可以由tangentNormal.xy**计算而得。由于我们使用的是切线空间下的法线纹理,因此可以保证法线方向的z分量为正。

最后添加合适的回调函数

1

FallBack "Specular"

6.2.4 - 在世界空间下计算

基本思路:

- 在顶点着色器中计算从切线空间到世界空间的变换矩阵,然后将它传递给片元着色器

- 在片元着色器中把法线纹理中的法线方向从切线空间变换到世界空间下

尽管这种方法需要更多的计算,但在需要使用Cubemap进行环境映射的情况下,我们就需要这种方法。

实现如下:

复制之前的代码,修改顶点着色器的输出v2f

1

2

3

4

5

6

7

8struct v2f

{

float4 vertex : SV_POSITION;

float4 uv : TEXCOORD0;

float4 TtoW0 : TEXCOORD1;

float4 TtoW1 : TEXCOORD2;

float4 TtoW2 : TEXCOORD4;

};插值寄存器最多只能存储float4大小的变量,对于矩阵这样的变量,我们可以把它们按行拆成多个变量再进行存储。上面代码中的TtoW0、TtoW1和 TtoW2 就依次存储了从切线空间到世界空间的变换矩阵的每一行。实际上,对方向矢量的变换只需要使用3×3大小的矩阵,也就是说,每一行只需要使用float3类型的变量即可。但为了充分利用插值寄存器的存储空间,我们把世界空间下的顶点位置存储在这些变量的w分量中。

修改顶点着色器,计算从切线空间到世界空间的变换矩阵

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

//为了减少寄存器的使用,将贴图存储到一个纹理坐标中

o.uv.xy = v.uv.xy * _MainTex_ST.xy + _MainTex_ST.zw;

o.uv.zw = v.uv.xy * _BumpMap_ST.xy + _BumpMap_ST.zw;

// o.uv.xy = TRANSFORM_TEX(v.uv.xy, _MainTex);

// o.uv.zw = TRANSFORM_TEX(v.uv.xy, _BumpMap);

float3 worldPos = mul(unity_ObjectToWorld, v.vertex).xyz;

fixed3 worldNormal = UnityObjectToWorldNormal(v.normal);

fixed3 worldTangent = UnityObjectToWorldDir(v.tangent.xyz);

fixed3 worldBinormal = cross(worldNormal, worldTangent) * v.tangent.w;

o.TtoW0 = float4(worldTangent.x, worldBinormal.x, worldNormal.x, worldPos.x);

o.TtoW1 = float4(worldTangent.y, worldBinormal.y, worldNormal.y, worldPos.y);

o.TtoW2 = float4(worldTangent.z, worldBinormal.z, worldNormal.z, worldPos.z);

return o;

}修改片元着色器

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26fixed4 frag (v2f i) : SV_Target

{

float3 worldPos = float3(i.TtoW0.w, i.TtoW1.w, i.TtoW2.w);

fixed3 lightDir = normalize(UnityWorldSpaceLightDir(worldPos));

fixed3 viewDir = normalize(UnityWorldSpaceViewDir(worldPos));

fixed3 bump = UnpackNormal(tex2D(_BumpMap, i.uv.zw));

bump.xy *= _BumpScale;

bump.z = sqrt(1.0 - saturate(dot(bump.xy, bump.xy)));

bump = normalize(half3(dot(i.TtoW0.xyz, bump), dot(i.TtoW1.xyz, bump), dot(i.TtoW2.xyz, bump)));

fixed3 albedo = tex2D(_MainTex, i.uv).rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(bump, lightDir));

fixed3 halfDir = normalize(lightDir + viewDir);

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0, dot(bump, halfDir)), _Gloss);

return fixed4(ambient + diffuse + specular, 1.0);

}- 我们首先从TtoW0、TtoW1和 TtoW2的w分量中构建世界空间下的坐标。

- 然后,使用内置的UnityWorldSpaceLightDir和 UnityWorldSpaceViewDir函数得到世界空间下的光照和视角方向。

- 接着,我们使用内置的 UnpackNormal函数对法线纹理进行采样和解码(需要把法线纹理的格式标识成Normal map),并使用 BumpScale对其进行缩放。

- 最后,我们使用TtoW0、TtoW1和 TtoW2存储的变换矩阵把法线变换到世界空间下。这是通过使用点乘操作来实现矩阵的每一行和法线相乘来得到的。

从视觉表现上,在切线空间下和在世界空间下计算光照几乎没有任何差别。

6.2.5 - Unity中的法线纹理类型

当把法线纹理的纹理类型标识成Normal map时,可以使用 Unity的内置函数 UnpackNormal来得到正确的法线方向

当我们需要使用那些包含了法线映射的内置的Unity Shader时,必须把使用的法线纹理按上面的方式标识成Normal map才能得到正确结果(即便你忘了这么做,Unity 也会在材质面板中提醒你修正这个问题),这是因为这些Unity Shader都使用了内置的UnpackNormal 函数来采样法线方向。那么,当我们把纹理类型设置成 Normal map时到底发生了什么呢?为什么要这么做呢?

简单来说,这么做可以让Unity 根据不同平台对法线方向时,需要把纹理类型标识为Normal map纹理进行压缩(例如使用 DXT5nm格式),再通过 UnpackNormal函数来针对不同的压缩格式对法线纹理进行正确的采样。我们可以在 UnityCGcginc里找到UnpackNormal函数的内部实现:

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

{

fixed3 normal;

normal.xy=packednormal .wy * 2-1;

normal.z = sqrt(l- saturate(dot(normal.xy, normal.xy)));

return normal;

}

inline fixed3 UnpackNormal(fixed4 packednormal)

{

#if defined (UNITY NO DXT5nm)

return packednormal.xyz *2- 1;

#else

return UnpackNormalDXT5nm(packednormal);

#endif

}从代码中可以看出,在某些平台上由于使用了DXT5nm的压缩格式,因此需要针对这种格式对法线进行解码。在 DXT5nm格式的法线纹理中,纹素的a通道(即w分量)对应了法线的r分量,g通道对应了法线的y分量,而纹理的r和b通道则会被舍弃,法线的z分量可以由xy分量推导而得。

为什么之前的普通纹理不能按这种方式压缩,而法线就需要使用DXT5nm格式来进行压缩呢?这是因为,按我们之前的处理方式,法线纹理被当成一个和普通纹理无异的图,但实际上,它只有两个通道是真正必不可少的,因为第三个通道的值可以用另外两个推导出来(法线是单位向量,并且切线空间下的法线方向的z分量始终为正)。使用这种压缩方法就可以减少法线纹理占用的内存空间。

当我们把纹理类型设置成Normal map后,还有一个复选框是Create from Grayscale,这个复选框就是用于从高度图中生成法线纹理的。高度图本身记录的是相对高度,是一张灰度图,白色表示相对更高,黑色表示相对更低。当我们把张高度图导入Unity后,除了需要把它的纹理类型设置成Normal map外,还需要勾选 Create from Grayscale,然后,我们就可以把它和切线空间下的法线纹理同等对待了。

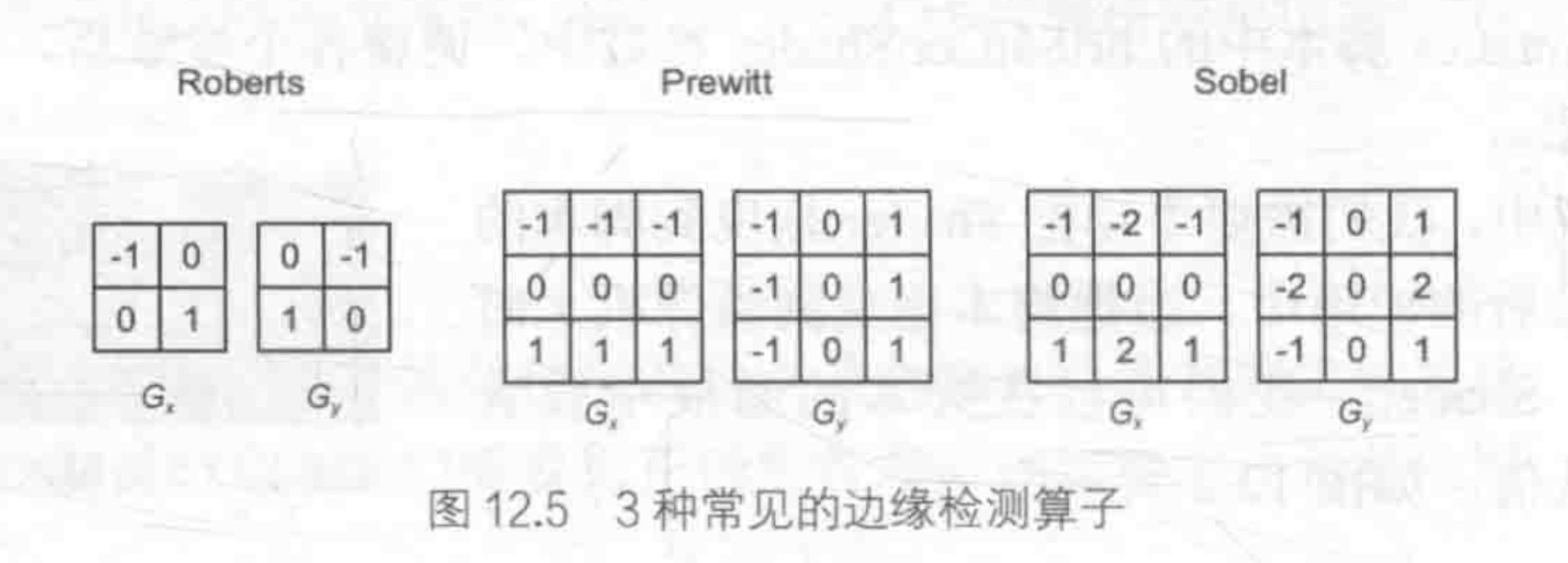

当勾选了Create from Grayscale后,还多出了两个选项——Bumpiness和 Filtering。其中Bumpiness用于控制凹凸程度,而Filtering 决定我们使用哪种方式来计算凹凸程度,它有两种选项:一种是Smooth,这使得生成后的法线纹理会比较平滑;另一种是Sharp,它会使用Sobel滤波(一种边缘检测时使用的滤波器)来生成法线。Sobel滤波的实现非常简单,我们只需要在一个3×3的滤波器中计算x和y方向上的导数,然后从中得到法线即可。具体方法是:对于高度图中的每个像素,我们考虑它与水平方向和竖直方向上的像素差,把它们的差当成该点对应的法线在x和y方向上的位移,然后使用之前提到的映射函数存储成到法线纹理的r和g分量即可。

6.3 - 渐变映射

实现如下:

在Properties语义块中声明以下属性:

1

2

3

4

5

6

7Properties

{

_Color ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

_RampTex ("Ramp Tex", 2D) = "white" {}

_Specular ("Specular", Color) = (1.0, 1.0, 1.0, 1.0)

_Gloss ("", Range(8.0, 256)) = 20

}配置光照模式、声明变量、引入内置文件

修改顶点着色器的输入结构体

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16struct appdata

{

float4 vertex : POSITION;

float4 uv : TEXCOORD0;

float3 normal : NORMAL;

};

struct v2f

{

float2 uv : TEXCOORD2;

float4 vertex : SV_POSITION;

float3 worldNormal : TEXCOORD0;

float3 worldPos : TEXCOORD1;

};修改顶点着色器

1

2

3

4

5

6

7

8

9

10v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.worldPos = mul(unity_ObjectToWorld, v.vertex).xyz;

o.uv = TRANSFORM_TEX(v.uv, _RampTex);

return o;

}修改片元着色器

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20fixed4 frag (v2f i) : SV_Target

{

fixed3 worldNormal = normalize(i.worldNormal);

fixed3 worldLightDir = normalize(UnityWorldSpaceLightDir(i.worldPos));

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

fixed halfLambert = dot(worldNormal,worldLightDir) * 0.5 + 0.5;

fixed3 diffuseColor = tex2D(_RampTex, fixed2(halfLambert, halfLambert)).rgb * _Color.rgb;

fixed3 diffuse = _LightColor0.rgb * diffuseColor;

fixed3 viewDir = normalize(UnityWorldSpaceViewDir(i.worldPos));

fixed3 halfDir = normalize(worldLightDir + viewDir);

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0, dot(0, dot(worldNormal, halfDir))), _Gloss);

return fixed4(ambient + diffuse + specular, 1.0);

}- 在上面的代码中,我们使用半兰伯特模型,通过对法线方向和光照方向的点积做一次0.5倍的缩放以及一个0.5大小的偏移来计算半兰伯特部分 halfLambert。这样,我们得到的halfLambert的范围被映射到了**[0,1]**之间。

- 之后,我们使用 halfLambert 来构建一个纹理坐标,并用这个纹理坐标对渐变纹理 RampTex进行采样。由于 RampTex实际就是一个一维纹理(它在纵轴方向上颜色不变),因此纹理坐标的u和v方向我们都使用了halfLambert。

- 然后,把从渐变纹理采样得到的颜色和材质颜色 Color相乘,得到最终的漫反射颜色。剩下的代码就是计算高光反射和环境光,并把它们的结果进行相加。

最后添加合适的回调函数

1

FallBack "Specular"

需要注意的是,我们需要把渐变纹理的 Wrap Mode设为Clamp模式,以防止对纹理进行采样时由于浮点数精度而造成的问题。

使用Repeat模式中在高光区域有一些黑点。这是由浮点精度造成的,当我们使用fixed2(halfLambert,halfLambert)对渐变纹理进行采样时,虽然理论上halfLambert 的值在[0,1]之间,

但可能会有1.000 01这样的值出现。如果我们使用的是Repeat模式,此时就会舍弃整数部分,只保留小数部分,得到的值就是0.00001,对应了渐变图中最左边的值,即黑色。因此,就会出现图中这样在高光区域反而有黑点的情况。我们只需要把渐变纹理的Wrap Mode设为Clamp模式就可以解决这种问题。

6.4 - 遮罩映射

遮罩纹理(mask texture)允许我们可以保护某些区域,使它们免于某些修改。

例如,我们希望模型表面某些区域的反光强烈一些,而某些区域弱一些。为了得到更加细腻的效果,我们就可以使用一张遮罩纹理来控制光照。

另一种常见的应用是在制作地形材质时需要混合多张图片,例如表现草地的纹理、表现石子的纹理、表现裸露土地的纹理等,使用遮罩纹理可以控制如何混合这些纹理。

实现如下:

在Properties语义块中声明以下属性:

1

2

3

4

5

6

7

8

9

10

11Properties

{

_MainTex ("Texture", 2D) = "white" {}

_Color ("Color", Color) = (1.0, 1.0, 1.0, 1.0)

_Specular ("Specular", Color) = (1.0, 1.0, 1.0, 1.0)

_Gloss ("", Range(8.0, 256)) = 20

_BumpMap ("BumpMap", 2D) = "Bump" {}

_BumpScale ("BumpScale", Float) = 1.0

_SpecularScale ("SpecularScale", Float) = 1.0

_SpecularMask ("SpecularMask", 2D) = "Bump" {}

}配置光照模式、声明变量、引入内置文件

1

2

3

4

5

6

7

8

9

10sampler2D _MainTex;

float4 _MainTex_ST;

fixed4 _Color;

sampler2D _BumpMap;

float _BumpScale;

sampler2D _SpecularMask;

float _SpecularScale;

fixed4 _Specular;

float _Gloss;我们为主要纹理**_MainTex、法线纹理_BumpMap、遮罩纹理_SpecularMask定义了他们共同使用的纹理属性变量_MainTex_ST**。在属性中修改主要纹理的平铺系数和偏移系数会同时影响3个纹理的采样。这样做可以节省需要存储的纹理坐标数目。

修改顶点着色器的输入结构体

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16struct appdata

{

float4 vertex : POSITION;

float4 uv : TEXCOORD0;

float3 normal : NORMAL;

};

struct v2f

{

float2 uv : TEXCOORD2;

float4 vertex : SV_POSITION;

float3 worldNormal : TEXCOORD0;

float3 worldPos : TEXCOORD1;

};修改顶点着色器

1

2

3

4

5

6

7

8

9

10v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.worldNormal = UnityObjectToWorldNormal(v.normal);

o.worldPos = mul(unity_ObjectToWorld, v.vertex).xyz;

o.uv = TRANSFORM_TEX(v.uv, _RampTex);

return o;

}修改片元着色器

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26fixed4 frag (v2f i) : SV_Target

{

fixed3 lightDir = normalize(i.lightDir);

fixed3 viewDir = normalize(i.viewDir);

//解析法线贴图

fixed3 tangentNormal = UnpackNormal(tex2D(_BumpMap, i.uv));

tangentNormal.xy *= _BumpScale;

tangentNormal.z = sqrt(1.0 - saturate(dot(tangentNormal.xy, tangentNormal.xy)));

fixed3 albedo = tex2D(_MainTex, i.uv).rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(tangentNormal, lightDir));

fixed3 halfDir = normalize(lightDir + viewDir);

fixed specularMask = tex2D(_SpecularMask, i.uv).r * _SpecularScale;

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0, dot(tangentNormal, halfDir)), _Gloss) * specularMask;

return fixed4(ambient + diffuse + specular, 1.0);

}- 环境光照和漫反射光照和之前使用过的代码完全一样。在计算高光反射时,我们首先对遮罩纹理**_SpecularMask进行采样。由于本书使用的遮罩纹理中每个纹素的rgb分量其实都是一样的,表明了该点对应的高光反射强度,在这里我们选择使用r分量来计算掩码值。然后,我们用得到的掩码值和_SpecularScale**相乘,一起来控制高光反射的强度。

- 需要说明的是,我们使用的这张遮罩纹理其实有很多空间被浪费了——它的rgb分量存储的都是同一个值。在实际的游戏制作中,我们往往会充分利用遮罩纹理中的每一个颜色通道来存储不同的表面属性。

在真实的游戏制作过程中,遮罩纹理已经不止限于保护某些区域使它们免于某些修改,而是可以存储任何我们希望逐像素控制的表面属性。通常,我们会充分利用一张纹理的RGBA四个通道,用于存储不同的属性。例如,我们可以把高光反射的强度存储在R通道,把边缘光照的强度存储在G通道,把高光反射的指数部分存储在B通道,最后把自发光强度存储在A通道。

在游戏《DOTA2》的开发中,开发人员为每个模型使用了4张纹理:一张用于定义模型颜色,一张用于定义表面法线,另外两张则都是遮罩纹理。这样,两张遮罩纹理提供了共8种额外的表面属性,这使得游戏中的人物材质自由度很强,可以支持很多高级的模型属性。

7 - 透明效果

在 Unity中,我们通常使用两种方法来实现透明效果:

第一种是使用透明度测试(Alpha Test),这种方法其实无法得到真正的半透明效果;

透明度测试:它采用一种“霸道极端”的机制,只要一个片元的透明度不满足条件(通常

是小于某个阈值),那么它对应的片元就会被舍弃。它产生的效果也很极端,要么完全透明,即看不到,要么完全不透明,就像不透明物体那样。

另一种是透明度混合(Alpha Blending)

透明度混合:这种方法可以得到真正的半透明效果。它会使用当前片元的透明度作为混合因子,与已经存储在颜色缓冲中的颜色值进行混合,得到新的颜色。但是,透明度混合需要关闭深度写入,这使得我们要非常小心物体的渲染顺序。

需要注意的是,透明度混合只关闭了深度写入,但没有关闭深度测试。这意味着,当使用透明度混合渲染一个片元时,还是会比较它的深度值与当前深度缓冲中的深度值,如果它的深度值距离摄像机更远,那么就不会再进行混合操作。这一点决定了,当一个不透明物体出现在一个透明物体的前面,而我们先渲染了不透明物体,它仍然可以正常地遮挡住透明物体。也就是说,对于透明度混合来说,深度缓冲是只读的。

对于透明度混合技术,需要关闭深度写入,此时我们就需要小心处理透明物体的渲染顺序。

那么,我们为什么要关闭深度写入呢?如果不关闭深度写入,一个半透明表面背后的表面本来是可以透过它被我们看到的,但由于深度测试时判断结果是该半透明表面距离摄像机更近,导致后面的表面将会被剔除,我们也就无法透过半透明表面看到后面的物体了。但是,我们由此就破坏了深度缓冲的工作机制,关闭深度写入导致渲染顺序将变得非常重要。

7.1 - Unity Shader的渲染顺序

Unity为了解决渲染顺序提供了渲染队列,SubShader的Queue标签来决定我们的模型归于哪个渲染队列,索引号越小表示越早被渲染。

| 名称 | 队列索引号 | 描述 |

|---|---|---|

| Background | 1000 | 这个渲染队列会在任何其他队列之前被渲染,我们通常使用该队列来渲染那些需要绘制在背景上的物体 |

| Geometry | 2000 | 默认的渲染队列,大多数物体都使用这个队列。不透明物体使用这个队列 |

| AlphaTest | 2450 | 需要透明度测试的物体使用这个队列。在 Unity 5中它从 Geometry 队列中被单独分出来,这是因为在所有不透明物体渲染之后再渲染它们会更加高效 |

| Transparent | 3000 | 这个队列中的物体会在所有 Geometry和 AlphaTest物体渲染后,再按从后往前的顺序进行渲染。任何使用了透明度混合(例如关闭了深度写入的 Shader)的物体都应该使用该队列 |

| Overlay | 4000 | 该队列用于实现一些叠加效果。任何需要在最后渲染的物体都应该使用该队列 |

因此,如果想通过透明度测试实现透明效果,代码中应包含以下:

2

3

4

5

6

7

{

Tags { "Queue"="AlphaTest" }

Pass {

...

}

}

如果想通过透明度混合测试实现透明效果,代码中应包含以下:

2

3

4

5

6

7

8

{

Tags { "Queue"="Transparent" }

Pass {

Zwrite off

...

}

}其中,ZWrite Off用于关闭深度写入,在这里我们选择把它写在Pass中。我们也可以把它写在 SubShader 中,这意味着该SubShader下的所有Pass都会关闭深度写入。

7.3 - 透明度测试

透明度测试:只要一个片元的透明度不满足条件(通常是小于某个阈值),那么它对应的片元就会被舍弃。被舍弃的片元将不会再进行任何处理,也不会对颜色缓冲产生任何影响;否则,就会按照普通的不透明物体的处理方式来处理它。

通常,我们会在片元着色器中使用clip函数来进行透明度测试。clip是CG 中的一个函数,如果给定参数的任何一个分量是负数,就会舍弃当前像素的输出颜色。

Shader:Chapter8-AlphaTest

实现如下:

定义属性,声明一个范围在[0,1]的属性

_Cutoff用来控制是否透明定义Tag

1

2

3

4

5

6

7SubShader

{

Tags {

"Queue"="AlphaTest"

"IgnoreProjector"="True"

"RenderType"="TransparentCutout"

}- 透明度测试使用的渲染队列是名为

AlphaTest的队列,因此我们需要把Queue标签设置为AlphaTest。 - 而 RenderType标签可以让Unity把这个Shader归入到提前定义的组(这里就是

TransparentCutout组)中,以指明该Shader是一个使用了透明度测试的 Shader。RenderType标签通常被用于着色器替换功能。 - 把

IgnoreProjector设置为True,这意味着这个 Shader 不会受到投影器(Projectors)的影响。

- 透明度测试使用的渲染队列是名为

包含内置文件、声明变量、定义顶点着色器以及它的输入和输出结构体

修改片元着色器:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17fixed4 frag (v2f i) : SV_Target

{

fixed3 worldNormal = normalize(i.worldNormal);

fixed3 WorldLightDir = normalize(UnityWorldSpaceLightDir(i.worldPos));

fixed4 texColor = tex2D(_MainTex, i.uv);

clip(texColor.a - _Cutoff);

fixed3 albedo = texColor.rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(worldNormal, WorldLightDir));

return fixed4(ambient + diffuse, 1.0);

}使用clip函数判断参数

texColor.a是否小于材质参数_Cutoff,是就舍弃该片元的输出。选择合适的FallBack

1

FallBack "Transparent/Cutout/VertexLit"

7.4 - 透明度混合

为了进行混合,我们需要使用Unity提供的混合命令:Blend,以下是ShaderLab的Blend命令。

| 语义 | 描述 |

|---|---|

| Blend Off | 关闭混合 |

| Blend SrcFactor DstFactor | 开启混合,并设置混合因子。源颜色(该片元产生的颜色)会乘以SrcFactor,而目标颜色(已经存在于颜色缓存的颜色)会乘以 DstFactor,然后把两者相加后再存入颜色缓冲 |

| Blend SrcFactor DstFactor, SrcFactorA DstFactorA | 和上面几乎一样,只是使用不同的因子来混合透明通道 |

| BlendOp BlendOperation | 并非是把源颜色和目标颜色简单相加后混合,而是使用BlendOperation对它们进行其他操作 |

Shader:Chapter8-AlphaBlend

实现如下:

定义属性,声明一个范围在[0,1]的属性

_AlphaScale用来控制透明度定义Tag

1

2

3

4

5

6

7SubShader

{

Tags {

"Queue"="Transparent"

"IgnoreProjector"="True"

"RenderType"="Transparent"

}- 透明度混合使用的渲染队列是名为

Transparent的队列,因此我们需要把Queue标签设置为Transparent。 - 而 RenderType标签可以让Unity把这个Shader归入到提前定义的组(这里就是

Transparent组)中,以指明该Shader是一个使用了透明度混合的 Shader。RenderType标签通常被用于着色器替换功能。 - 把

IgnoreProjector设置为True,这意味着这个 Shader 不会受到投影器(Projectors)的影响。

- 透明度混合使用的渲染队列是名为

与透明度测试不同的是,我们还需要在Pass中为透明的混合进行合适的混合状态设置

1

2

3

4

5

6Pass

{

Tags { "LightMode" = "ForwardBase" }

Zwrite Off

Blend SrcAlpha OneMinusSrcAlphaPass的标签仍和之前一样,即把

LightMode设为ForwardBase,这是为了让 Unity 能够按前向渲染路径的方式为我们正确提供各个光照变量。除此之外,我们还把该Pass 的深度写入(ZWrite)设置为关闭状态(Off)

然后,我们开启并设置了该Pass 的混合模式。我们将源颜色(该片元着色器产生的颜色)的混合因子设为

SrcAlpha,把目标颜色(已经存在于颜色缓冲中的颜色)的混合因子设为OneMinusSrcAlpha,以得到合适的半透明效果。包含内置文件、声明变量、定义顶点着色器以及它的输入和输出结构体

修改片元着色器:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16fixed4 frag (v2f i) : SV_Target

{

fixed3 worldNormal = normalize(i.worldNormal);

fixed3 WorldLightDir = normalize(UnityWorldSpaceLightDir(i.worldPos));

fixed4 texColor = tex2D(_MainTex, i.uv);

fixed3 albedo = texColor.rgb * _Color.rgb;

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz * albedo;

fixed3 diffuse = _LightColor0.rgb * albedo * max(0, dot(worldNormal, WorldLightDir));

return fixed4(ambient + diffuse, texColor.a * _AlphaScale);

}唯一的更改的设置了该片元着色器返回值中的透明通道

选择合适的FallBack

1

Fallback "Transparent/vertexLit"

由于网格有复杂结构,这个透明效果仍不够好,仍然需要使用深入写入来优化

7.5 - 开启深度写入的半透明效果

Shader:Chapter8-AlphaBlendZWrite

实现如下:

使用Chapter8-AlphaBlend中的代码,在此基础上在原来的Pass前面添加一个新的Pass即可

2

3

4

5

{

Zwrite On

ColorMask 0

}

- 这个新添加的Pass的目的仅仅是为了把模型的深度信息写入深度缓冲中,从而剔除模型中被自身遮挡的片元。因此,Pass的第一行开启了深度写入。

- 在第二行,我们使用了一个新的渲染命

ColorMask。在ShaderLab 中,ColorMask用于设置颜色通道的写掩码(write mask)。当ColorMask设为0时,意味着该Pass 不写入任何颜色通道,即不会输出任何颜色。这正是我们需要的——该Pass只需写入深度缓存即可。

7.6 - ShaderLab的混合指令

7.6.1 - 混合等式和参数

混合是一个逐片元的操作,而且它不是可编程的,但却是高度可配置的。也就是说,我们可以设置混合时使用的运算操作、混合因子等来影响混合。

| 命令 | 描述 |

|---|---|

| Blend SrcFactor DstFactor | 开启混合,并设置混合因子。源颜色(该片元产生的颜色)会乘以SrcFactor,而目标颜色(已经存在于颜色缓存的颜色)会乘以DstFactor,然后把两者相加后再存入颜色缓冲中 |

| Blend SrcFactor DstFactor, SrcFactor A DstFactorA | 和上面几乎一样,只是使用不同的因子来混合透明通道 |

7.6.2 - 常见的混合类型

通过混合操作和混合因子命令的组合,我们可以得到一些类似 Photoshop混合模式中的混合效果:

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

Blend SrcAlpha OneMinusSrcAlpha

// Soft Additive 柔和相加

Blend OneMinusDstColor One

// Multiply 正片叠底

Blend DstColor Zero

// 2x Multiply 两倍相乘

Blend DstColor SrcColor

// Darken 变暗

BlendOp Min

Blend One One // When using Min operation, these factors are ignored

// Lighten 变亮

BlendOp Max

Blend One One // When using Max operation, these factors are ignored

// Screen 滤色

Blend OneMinusDstColor One

//等同于

Blend One OneMinusSrcColor

// Linear Dodge 线性减淡

Blend One One

7.7 - 双面渲染的透明效果

7.7.1 - 透明度测试的双面渲染

这节的代码和透明度测试的代码几乎一样,只是在Pass语义块中加了一行:

2

3

4

5

{

Tags { "LightMode" = "ForwardBase" }

Cull off

7.7.2 - 透明度混合的双面渲染

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

{

Tags {

"Queue"="Transparent"

"IgnoreProjector"="True"

"RenderType"="Transparent"

}

Pass

{

Tags { "LightMode" = "ForwardBase" }

Cull Front

...

}

Pass

{

Tags { "LightMode" = "ForwardBase" }

Cull Back

...为此,我们选择把双面渲染的工作分成两个Pass-第一Pass只渲染背面,第二个Pass只渲染正面,由于Unity会顺序执行SubShader中的各个Pass,因此我们可以保证背面总是在正面被渲染之前渲染,从而可以保证正确的深度渲染关系。

8 - 复杂光照

8.1 - Unity的渲染路径

在Unity中,渲染路径(Render Path)决定了光照是如何应用到Unity Shader中的。如果要和光源打交道,那么我们需要为每个Pass指定它使用的渲染路径。

LightMode标签支持的渲染路径选项:

| 标签名 | 描述 |

|---|---|

| Always | 不管使用哪种渲染路径,该Pass总是会被渲染,但不会计算任何光照 |

| ForwardBase | 用于前向渲染。该Pass 会计算环境光、最重要的平行光、逐顶点/SH光源和 Lightmaps |

| ForwardAdd | 用于前向渲染。该Pass会计算额外的逐像素光源,每个Pass对应一个光源 |

| Deferred | 用于延迟渲染。该Pass会渲染G缓冲(G-buffer) |

| ShadowCaster | 把物体的深度信息渲染到阴影映射纹理(shadowmap)或一张深度纹理中 |

8.1.1 - 向前渲染路径

向前渲染路径的原理:

每进行一次完整的向前渲染,我们需要渲染该对象的图元,并计算两个缓冲区的信息,一个是颜色缓冲区,一个是深度缓冲区。我们利用深度缓冲来决定一个片元是否可见,如果可见就更新颜色缓冲区中的颜色值。

对于每个逐像素光源,我们都需要进行上面一次完整的渲染流程。如果一个物体在多个逐像素光源的影响区域内,那么该物体就需要执行多个 Pass,每个 Pass计算一个逐像素光源的光照结果,然后在帧缓冲中把这些光照结果混合起来得到最终的颜色值。假设,场景中有N个物体,每个物体受M个光源的影响,那么要渲染整个场景一共需要N*M个 Pass。可以看出,如果有大量逐像素光照,那么需要执行的Pass数目也会很大。因此,渲染引擎通常会限制每个物体的逐像素光照的数目。

Unity中的向前渲染:

一共Pass不仅仅可以用来计算逐像素光照,它也可以用来计算逐顶点等其他光照。

在Unity中,向前渲染路径有3种处理光照的方式,逐顶点处理,逐像素处理,球谐函数处理(Spherical Harmonics,SH)。

光源模式指的是该光源是否是重要的(Important),如果一个光源被设置成重要的,那么它就会被逐像素处理。

Unity会根据场景中各个光源的设置以及这些光源对物体的影响程度(例如距离物体的远近、光源强度等),对这些光源进行一个重要度的排序。其中,一定数目的光源会按逐像素的方式处理,然后最多有4个光源按逐顶点的方式处理,剩下的光源可以按 SH方式处理。Unity 使用的判断规则如下。

- 场景中最亮的平行光总是按逐像素处理的。

- 渲染模式被设置成 Not Important的光源,会按逐顶点或者SH处理。

- 渲染模式被设置成Important的光源,会按逐像素处理。

- 如果根据以上规则得到的逐像素光源数量小于Quality Setting 中的逐像素光源数量(PixelLight Count),会有更多的光源以逐像素的方式进行渲染。

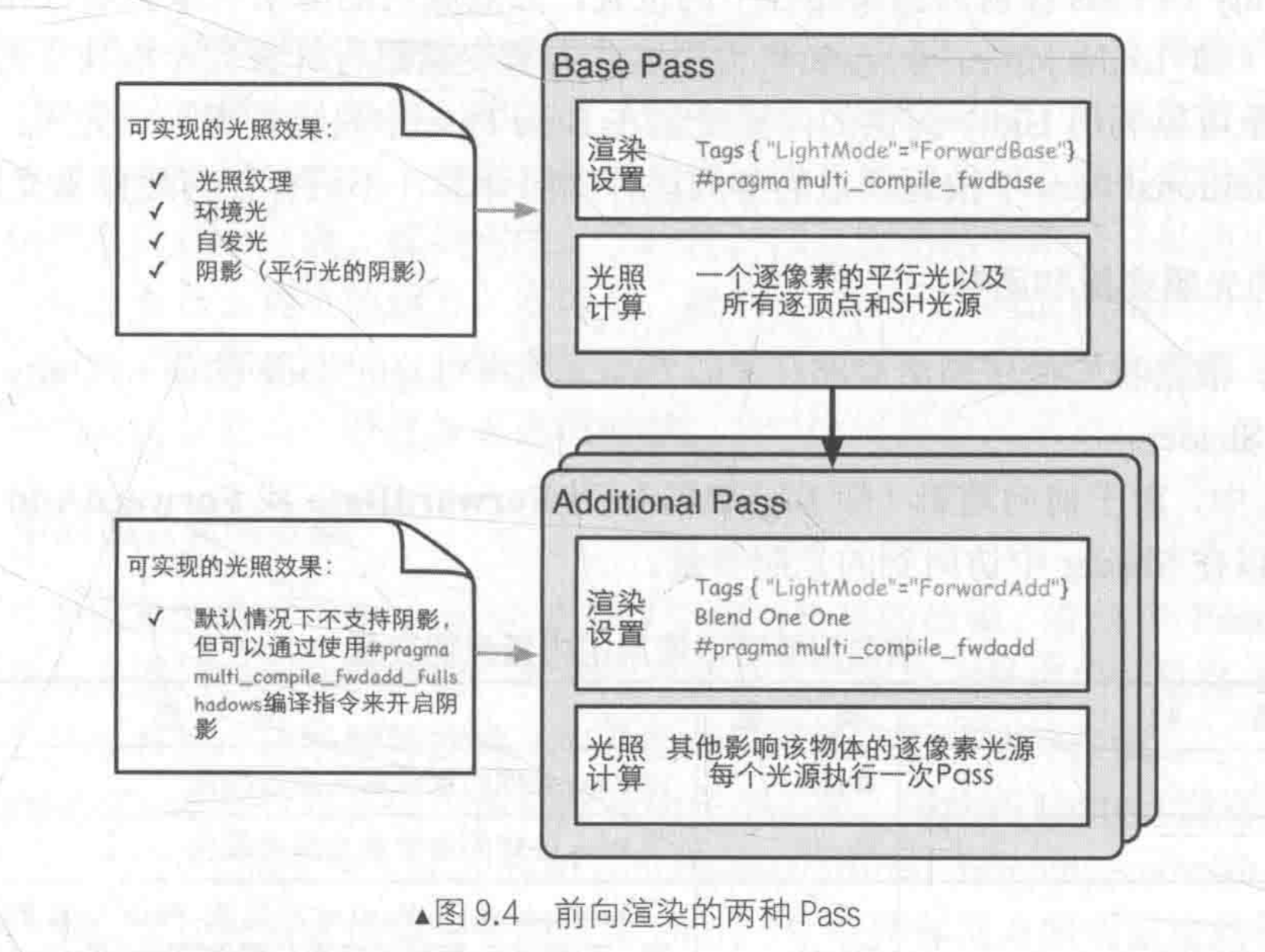

Unity的光照在Pass中进行计算,向前渲染有两种Pass:Base Pass和Additional Pass。

对于前向渲染来说,一个Unity Shader通常会定义一个 Base Pass(Base Pass也可以定义多次,例如需要双面渲染等情况)以及Additional Pass。一个 Base Pass仅会执行一次(定义了多个 Base Pass的情况除外),

而一个Additional Pass会根据影响该物体的其他逐像素光源的数目被多次调用,即每个逐像素光源会执行一次Additional Pass。

向前渲染路径中可以使用的内置光照变量:

| 名称 | 类型 | 描述 |

|---|---|---|

| _LightColor0 | float4 | 该Pass处理的逐像素光源的颜色 |

| _WorldSpaceLightPos0 | float4 | _WorldSpaceLightPos0.xyz是该 Pass处理的逐像素光源的位置。如果该光源是平行光,那么_WorldSpaceLightPos0.w是0,其他光源类型w值为1 |

| _LightMatrix0 | float4×4 | 从世界空间到光源空间的变换矩阵。可以用于采样cookie和光强衰减(attenuation)纹理 |

| unity_4LightPosX0, unity_4LightPosY0,unity_4LightPosZ0 | float4 | 仅用于 Base Pass。前4个非重要的点光源在世界空间中的位置 |

| unity_4LightAtten0 | float4 | 仅用于Base Pass。存储了前4个非重要的点光源的衰减因子 |

| unity_LightColor | half4[4] | 仅用于Base Pass。存储了前4个非重要的点光源的颜色 |

向前渲染中可以使用的内置光照函数:

| 函数名 | 描述 |

|---|---|

| float3 WorldSpaceLightDir(float4 v) | 仅可用于前向渲染中。输入一个模型空间中的顶点位置,返回世界空间中从该点到光源的光照方向。内部实现使用了Unity WorldSpaceLightDir函数。没有被归一化 |

| float3 UnityWorldSpaceLightDir(float4 v) | 仅可用于前向渲染中。输入一个世界空间中的顶点位置,返回世界空间中从该点到光源的光照方向。没有被归一化 |

| float3 ObjSpaceLightDir(float4 v) | 仅可用于前向渲染中。输入一个模型空间中的顶点位置,返回模型空间中从该点到光源的光照方向。没有被归一化 |

| float3 Shade4PointLights (…) | 仅可用于前向渲染中。计算四个点光源的光照,它的参数是已经打包进矢量的光照数据,通常就是表9.2中的内置变量,如 unity_4LightPosX0,unity_4LightPosY0,unity_ 4LightPosZ0、unity LightColor和 unity_4LightAtten0等。前向渲染通常会使用这个函数来计算逐顶点光照 |

8.1.2 - 顶点渲染路径

顶点照明渲染路径是对硬件配置要求最少、运算性能最高,但同时也是得到的效果最差的一种类型,它不支持那些逐像素才能得到的效果,例如阴影法线映射、高精度的高光反射等。实际上,它仅仅是前向渲染路径的一个子集,也就是说,所有可以在顶点照明渲染路径中实现的功能都可以在前向渲染路径中完成。就如它的名字一样,顶点照明渲染路径只是使用了逐顶点的方式来计算光照,并没有什么神奇的地方。实际上,我们在上面的前向渲染路径中也可以计算一些逐顶点的光源。但如果选择使用顶点照明渲染路径,那么Unity 会只填充那些逐顶点相关的光源变量,意味着我们不可以使用一些逐像素光照变量。

顶点照明渲染路径通常在一个 Pass中就可以完成对物体的渲染。在这个Pass中,我们会计算我们关心的所有光源对该物体的照明,并且这个计算是按逐顶点处理的。这是Unity 中最快速的渲染路径,并且具有最广泛的硬件支持。

8.1.3 - 延迟渲染路径

前向渲染的问题是:当场景中包含大量实时光源时,前向渲染的性能会急速下降。例如,如果我们在场景的某一块区域放置了多个光源,这些光源影响的区域互相重叠,那么为了得到最终的光照效果,我们就需要为该区域内的每个物体执行多个 Pass来计算不同光源对该物体的光照结果,然后在颜色缓存中把这些结果混合起来得到最终的光照。然而,每执行一个 Pass我们都需要重新渲染一遍物体,但很多计算实际上是重复的。

延迟渲染主要包含了两个Pass 。在第一个Pass中,我们不进行任何光照计算,而是仅仅计算哪些片元是可见的,这主要是通过深度缓冲技术来实现,当发现一个片元是可见的,我们就把它的相关信息存储到G缓冲区中。然后,在第二个 Pass中,我们利用G缓冲区的各个片元信息,例如表面法线、视角方向、漫反射系数等,进行真正的光照计算。

对于延迟渲染路径来说,它最适合在场景中光源数目很多、如果使用前向渲染会造成性能瓶颈的情况下使用。而且,延迟渲染路径中的每个光源都可以按逐像素的方式处理。但是,延迟渲染也有一些缺点。

- 不支持真正的抗锯齿(anti-aliasing)功能。

- 不能处理半透明物体。

- 对显卡有一定要求。如果要使用延迟渲染的话,显卡必须支持 MRT (Multiple RenderTargets)、Shader Mode 3.0及以上、深度渲染纹理以及双面的模板缓冲。

当使用延迟渲染时,Unity要求我们提供两个Pass。

(1)第一个 Pass用于渲染G缓冲。在这个 Pass中,我们会把物体的漫反射颜色、高光反射颜色、平滑度、法线、自发光和深度等信息渲染到屏幕空间的G缓冲区中。对于每个物体来说,这个Pass仅会执行一次。

(2)第二个Pass用于计算真正的光照模型。这个 Pass 会使用上一个Pass中渲染的数据来计算最终的光照颜色,再存储到帧缓冲中。

8.2 - Unity的光源类型

Unity一共支持四种光源类型:平行光、点光源、聚光灯和面光源(Area Light),面光源仅在烘焙时才可发挥作用。

8.2.1 - 在向前渲染中处理不同的光源类型

Shader:Chapter9-ForwardRendering

使用Blinn-Phone光照模型,并为向前渲染定义了Bass Pass 和 Additional Pass来处理多个光源。

定义第一个Pass - Base Pass

1

2

3

4

5

6

7

8

9Pass

{

// Base Shader

Tags { "LightMode" = "ForwardBase" }

CGPROGRAM

// Apparently need to add this declaration

#pragma multi_compile_fwdbase除了设置渲染路径以外,还是用了#pragma编译指令。

#pragma multi_compile_fwdbase可以保证我们在Shader中使用的光照衰减等光照变量可以被正确赋值。在Base Pass中计算环境光,我们希望环境光只计算一次,因此在之后的Additional Pass就不会在计算这个部分。与之类似的还有自发光。

1

fixed3 ambient = UNITY_LIGHTMODEL_AMBIENT.xyz;

然后,我们在Base Pass 中处理了场景中的最重要的平行光。我们可以使用**_WorldSpaceLightPos0来得到这个平行光的方向(位置对平行光来说没有意义),使用_LightColor0来得到它的颜色和强度(_LightColor0已经是颜色和强度相乘后的结果),由于平行光可以认为是没有衰减的,因此这里我们直接令衰减值为1.0**。

1

2

3

4

5

6

7

8

9fixed3 diffuse = _LightColor0.rgb * _Diffuse.rgb * max(0, dot(worldNormal,worldLight));

fixed3 specular = _LightColor0.rgb * _Specular.rgb * pow(max(0,dot(worldNormal, halfDir)),_Gloss);

fixed atten = 1.0;

fixed3 color = ambient + (diffuse + specular) * atten;

return fixed4(color, 1.0);- 如果场景中包含了多个平行光,Unity 会选择最亮的平行光传递给Base Pass-进行逐像素处理,其他平行光会按照逐顶点或在Additional Pass中按逐像素的方式处理。

- 如果场景中没有任何平行光,那么 Base Pass 会当成全黑的光源处理。每一个光源有5个属性:位置、方向、颜色、强度以及衰减。对于Base Pass来说,它处理的逐像素光源类型一定是平行光。

接下来,需要对场景其他像素定义Additional Pass

1

2

3

4

5

6

7

8

9

10Pass

{

// Additional Shader

Tags { "LightMode" = "ForwardAdd" }

Blend One One

CGPROGRAM

// Apparently need to add this declaration

#pragma multi_compile_fwdadd除了设置渲染路径标签外,我们同样使用了

#pragma multi_compile_fwdadd指令,如前面所

说,这个指令可以保证我们在Additional Pass 中访问到正确的光照变量。与Base Pass不同的是,我们还使用 Blend 命令开启和设置了混合模式。这是因为,我们希望 Additional Pass计算得到的光照结果可以在帧缓存中与之前的光照结果进行叠加。如果没有使用Blend命令的话,AdditionalPass 会直接覆盖掉之前的光照结果。在本例中,我们选择的混合系数是Blend One One,这不是必需的,我们可以设置成 Unity支持的任何混合系数。常见的还有Blend SrcAlpha One通常来说,Additional Pass中的光照处理和Base Pass中的处理方式是一样的,只需要去掉Base Pass中的环境光、自发光、逐顶点光照、SH光照的部分,并添加对不同光源的支持。

1

2

3

4

5#ifdef USING_DIRECTIONAL_LIGHT

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz);

#else

fixed3 worldLight = normalize(_WorldSpaceLightPos0.xyz - i.worldPos.xyz);

#endif在上面的代码中,我们首先判断了当前处理的逐像素光源的类型,这是通过使用#ifdef指令判断是否定义了

USING_DIRECTIONAL_LIGHT来得到的。如果当前前向渲染 Pass 处理的光源类型是平行光,那么Unity的底层渲染引擎就会定义USING DIRECTIONAL LIGHT。- 如果判断得知是平行光的话,光源方向可以直接由

WorldSpaceLightPos0.xyz得到; - 如果是点光源或聚光灯,那么

WorldSpaceLightPos0.xyz表示的是世界空间下的光源位置,而想要得到光源方向的话,我们就需要用这个位置减去世界空间下的顶点位置。

- 如果判断得知是平行光的话,光源方向可以直接由

最后,我们需要处理不同光源的衰减:

1

2

3

4

5

6

7

8

9

10

11

12

13#ifdef USING_DIRECTIONAL_LIGHT

fixed atten = 1.0;

#else

#if defined(POINT)

float3 lightCoord = mul(unity_WorldToLight, float4(i.worldPos, 1)).xyz;

fixed atten = tex2D(_LightTexture0, dot(lightCoord, lightCoord).rr).UNITY_ATTEN_CHANNEL;

#elif defined(SPOT)

float4 lightCoord = mul(unity_WorldToLight, float4(i.worldPos, 1));

fixed atten = (lightCoord.z > 0) * tex2D(_LightTexture0, lightCoord.xy / lightCoord.w + 0.5).w * tex2D(_LightTextureB0, dot(lightCoord, lightCoord).rr).UNITY_ATTEN_CHANNEL;

#else

fixed atten = 1.0;

#endif

#endif我们同样通过判断是否定义了

USING_DIRECTIONAL_LIGHT来决定当前处理的光源类型。- 如果是平行光的话,衰减值为1.0。

- 如果是其他光源类型,那么处理更复杂一些。Unity选择了使用一张纹理作为查找表(Lookup Table,LUT),以在片元着色器中得到光源的衰减。我们首先得到光源空间下的坐标,然后使用该坐标对衰减纹理进行采样得到衰减值。

当我们创建一个光源时,默认情况下它的 Render Mode(可以在 Light组件中设置)是Auto。这意味着,Unity 会在背后为我们判断哪些光源会按逐像素处理,而哪些按逐顶点或SH的方式处理。

由于我们没有更改Edit Project Settings - Quality →Pixel Light Count中的数值,因此默认情况下一个物体可以接收除最亮的平行光外的4个逐像素光照。

8.3 - Unity的光照衰减

Unity默认使用一张纹理:

_LightTexture0作为查找表来在片元着色器中计算逐像素光照的衰减

为了对**_LightTexture0**纹理采样得到给定点到该光源的衰减值;首先我们要得到该点在光源空间中的位置

然后,我们可以使用这个坐标的模的平方对衰减纹理进行采样,得到衰减值

可以发现,在上面的代码中,我们使用了光源空间中顶点距离的平方(通过dot函数来得到)来对纹理采样,之所以没有使用距离值来采样是因为这种方法可以避免开方操作。然后,我们使用宏UNITY_ATTEN_CHANNEL 来得到衰减纹理中衰减值所在的分量,以得到最终的衰减值。

8.4 - Unity的阴影

8.4.1 - 阴影是如何产生的

在实时渲染中,我们最常使用的是一种名为Shadow Map的技术,它的原理是:

首先会把摄像机放在于光源重合的位置,那么场景中该光源的阴影区域就是那些摄像机看不到的地方。

在向前渲染路径中,如果场景中最重要的平行光开启了阴影,Unity就会为该光源计算阴影映射纹理(Shadowmap),它本质上是一张深度图,记录了从该光源位置出发,能够看到的场景中距离它最近的表面位置(深度信息)。

由于我们只需要深度信息,因此Unity使用LightMode标签为ShadowCaster的Pass来更新阴影映射纹理。

如果我们想要一个物体接收来自其他物体的阴影,就必须在Shader中对阴影映射纹理(包括屏幕空间的阴影图)进行采样,然后把采样结果和最后的光照结果相乘来产生阴影效果。

如果我们想要一个物体向其他物体投射阴影,就必须把该物体加入到光源的阴影映射纹理的计算中,从而让其他物体在对阴影映射纹理采样时可以得到该物体的相关信息。

在Unity中,这个过程是通过为该物体执行

LightMode为ShadowCaster的Pass来实现的,如果使用了屏幕空间的投影映射技术,Unity还会使用这个Pass产生一张摄像机的深度纹理。

8.4.2 - 不透明物体的阴影

1.让物体投射阴影

在 Unity中,我们可以选择是否让一个物体投射或接收阴影。这是通过设置Mesh Renderer组件中的

Cast Shadows和Receive Shadows属性来实现的。在光源组件中,将

Strength设置为0.3,阴影类型为软阴影在默认情况下,计算光源的阴影映射纹理会剔除物体的背面,但对于内置的平面来说他只有一个面,在本例中,由于它右侧的平面在光源空间下没有任何正面,因此不会添加到阴影映射纹理中。可以将

Cast Shadows设置为Two Sided来允许对物体所有面都计算阴影信息。

最简单的方法是适合合适的FallBack,Unity会为我们选择LightMode为ShadowCaster的Pass。

可以在Untiy的内置着色器中找到他:

builtin_shaders-2023.1.2f1 -> DefaultResourcesExtra -> Normal-VertexLit.shader

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

Name "ShadowCaster"

Tags { "LightMode" = "ShadowCaster" }

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

#pragma target 2.0

#pragma multi_compile_shadowcaster

#pragma multi_compile_instancing // allow instanced shadow pass for most of the shaders

#include "UnityCG.cginc"

struct v2f {

V2F_SHADOW_CASTER;

UNITY_VERTEX_OUTPUT_STEREO

};

v2f vert( appdata_base v )

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v);

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(o);

TRANSFER_SHADOW_CASTER_NORMALOFFSET(o)

return o;

}

float4 frag( v2f i ) : SV_Target

{

SHADOW_CASTER_FRAGMENT(i)

}

ENDCG

}它的实际作用是将深度信息写入渲染目标中,这个Pass是可以在多个Unity Shader中通用的,因此可以直接使用FallBack回调。

2.让物体接受阴影

为Base Pass包含一个新的内置文件,这个文件包含我们计算阴影所用的宏

1

#include "AutoLight.cginc"

为顶点着色器输出结构体v2f添加一个内置宏SHADOW_COORDS

1

2

3

4

5

6

7struct v2f

{

float4 vertex : SV_POSITION;

float3 worldNormal : TEXCOORD0;

float3 worldPos : TEXCOORD1;

SHADOW_COORDS(2)

};- 这个宏的作用是声明一个用于阴影纹理采样的坐标

- 它的参数需要的是下一个可用的插值寄存器的索引值,这里是2。

在顶点着色器返回之前添加另一个内置宏TRANSFER_SHADOW

1

2

3

4

5

6

7

8

9

10v2f vert (appdata v)

{

v2f o;

...

// Pass shadow coordinates to pixel shader

TRANSFER_SHADOW(o);

return o;

}这个宏用于计算在v2f中声明的阴影纹理坐标

接着,在片元着色器中计算阴影值,这里同样使用了一个内置宏SHADOW_ATTENUATION

1

fixed shadow = SHADOW_ATTENUATION(i);

需要注意的是,这些宏会使用上下文变量来进行相关计算,例如TRANSFER_SHADOW会使用

v.vertex或a.pos来计算,因此为了能够让这些宏正确工作,我们需要保证自定义的变量名和这些宏中使用的变量名相匹配。我们需要保证:

a2f结构体中的顶点坐标变量名必须是vertex,顶点着色器的输出结构体v2f必须命名为v,且v2f中的顶点位置变量必须命名为pos.完成了上面的操作之后,我们只需要把阴影值shadow和漫反射以及高光反射颜色相乘即可。

8.4.3 - 统一管理光照衰减和阴影

光照衰减和阴影对物体最终的渲染结果的影响本质上是相同的,都是把光照衰减因子和阴影值及光照结果相乘得到最终的渲染结果。在Unity中,提供了一个方法来同时计算两个信息:UNITY_LIGHT_ATTENUATION

代码与Shadow类似,只有以下部分进行变更:

在片元着色器中使用宏UNITY_LIGHT_ATTENUATION来计算光照衰减和阴影

1

2

3

4

5

6

7fixed4 frag(v2f i) : SV_Target {

// UNITY_LIGHT_ATTENUATION not only compute attenuation, but also shadow infos

UNITY_LIGHT_ATTENUATION(atten, i, i.worldPos);

return fixed4((diffuse + specular) * atten, 1.0);

}

由于我们使用了UNITY_LIGHT_ATTENUATION,我们的Base Pass和Additional Pass的代码得以统一,不需要在Base Pass中单独处理阴影,也不需要在Additional Pass中判断光源的类型来处理光照衰减。

8.4.4 - 透明物体的阴影

对于大多数不透明物体来说,把 Fallback 设为VertexLit 就可以得到正确的阴影。但对于透明物体来说,我们就需要小心处理它的阴影。透明物体的实现通常会使用透明度测试或透明度混合,我们需要小心设置这些物体的FallBack,

Alpha Test

Shader:Chapter9-AlphaTestWithShadow

沿用了之前的Chapter8-AlphaTest的代码,在此基础上添加AutoLight内置文件以及宏,详见8.4.2 - 不透明物体的阴影 - 让物体接受阴影

并且更改回调函数为

1

FallBack "Transparent/Cutout/VertexLit"

如果使用了VertexLit,由于这个Pass没有进行任何透明的测试的计算,会把整个物体的深度信息渲染到深度图和阴影映射纹理中,会产生错误的结果。

由于一些面背对光源,没有进入阴影映射纹理的计算中,可以使Mesh Renderer中的Cast Shadows属性设置为Two Sided,强制计算所有面的深度信息。

Alpha Blend

在Unity中,所有内置的半透明Shader是不会产生任何阴影效果的,我们可以使用一些dirty trick来强制为半透明物体生成阴影:比如将他们的FallBack设置为VertexLit,Diffuse这些不透明物体使用的Shader。

8.5 - 标准Unity Shader

本书提供了两个这样标准的Unity Shader—BumpedDiffuse和 BumpedSpecular。这两个Unity Shader都包含了对法线纹理、多光源、光照衰减和阴影的相关处理,唯一不同的是,BumpedDifuse使用了Phong光照模型,而BumpedSpecular使用了Blinn-Phong光照模型。

9 - 高级纹理

9.1 - 立方体纹理

在图形学中,立方体纹理(Cubemap)是环境映射(Environment Mapping)的一种实现方法。环境映射可以模拟物体周围的环境,而使用了环境映射的物体可以看起来像镀了层金属一样反射出周围的环境。

- 使用立方体纹理的好处在于,它的实现简单快速,而且得到的效果也比较好。

- 但它也有一些缺点,例如当场景中引入了新的物体、光源,或者物体发生移动时,我们就需要重新生成立方体纹理。

除此之外,立方体纹理也仅可以反射环境,但不能反射使用了该立方体纹理的物体本身。这是因为,立方体纹理不能模拟多次反射的结果,例如两个金属球互相反射的情况.想要得到令人信服的渲染结果,我们应该尽量对凸面体而不要对凹面体使用立方体纹理(因为凹面体会反射自身)。

常见的立方体纹理应用有以下几种:

天空盒

环境映射